La regulación europea sobre IA: oportunidades, riesgos y escenarios de futuro con mirada metropolitana

Este documento recoge las conclusiones del seminario «La regulación europea sobre IA: oportunidades, riesgos y escenarios de futuro con mirada metropolitana», celebrado el 19 de septiembre de 2024 en la sede de CIDOB, con académicos y expertos en materia de regulación y gobernanza de las tecnologías de inteligencia artificial, tanto del sector público como privado. Este seminario se enmarca dentro del programa de investigación y prospectiva en geopolítica y relaciones internacionales de CIDOB, con el apoyo del Área Metropolitana de Barcelona (AMB). El programa tiene como objetivo aportar conocimiento al público general y especializado, generar publicaciones y debates, así como incorporar nuevas metodologías de prospectiva al análisis de los principales retos internacionales actuales.

La innovación social y tecnológica es crucial para responder a las necesidades de las personas y avanzar hacia gobiernos locales más inclusivos y equitativos. Tecnologías disruptivas como la inteligencia artificial (IA) abren nuevas oportunidades para mejorar la prestación de servicios públicos y la gestión de algunos de los retos urbanos más urgentes: la movilidad sostenible, la transición energética, el uso responsable del agua, o la reducción de la contaminación, entre otros. En los próximos años, la adopción creciente de la IA comportará una transformación de las administraciones públicas, que deben estar preparadas para encarar los nuevos desafíos y los riesgos asociados con el uso extensivo de sistemas algorítmicos. Hay que tener en cuenta, además, la doble responsabilidad de los gobiernos locales en cuanto que «consumidores» de soluciones tecnológicas, y «reguladores» que deben garantizar el marco adecuado para el desarrollo de una IA ética, segura, que respete la legalidad vigente, que sea compatible con nuestras normas sociales y culturales, y que ponga a las personas en el centro.

En este sentido, el Plan de Actuación Metropolitano (PAM) 2024-2027 de la AMB identifica la IA como uno de los principales focos de las políticas metropolitanas del futuro. Así, las ciudades metropolitanas deben estar preparadas para adoptar soluciones basadas en algoritmos y gestionar los riesgos que de ello se puedan derivar, pero también tienen que impulsar medidas políticas que les permitan competir, atraer talento y fidelizarlo, para avanzar en la consolidación de la AMB como metrópolis digital. Y todo ello lo tienen que llevar a cabo teniendo en cuenta el entorno normativo donde operan, que en un futuro vendrá condicionado por el Reglamento Europeo de Inteligencia Artificial (conocido como AI Act), aprobado recientemente, pero también las tendencias geopolíticas a escala global.

Este CIDOB Briefing busca contribuir a la reflexión sobre cómo deberían prepararse los gobiernos locales para encarar con éxito los retos asociados a la adopción de la inteligencia artificial. En la primera parte, se analizarán las implicaciones de la regulación europea de la IA para los gobiernos locales y las áreas metropolitanas; mientras que, en la segunda, se presentarán los resultados del ejercicio de prospectiva llevado a cabo en el marco del seminario, donde se identificaron algunos futuros deseados para la gobernanza de la inteligencia artificial, las principales incertidumbres que estos pueden condicionar, y cuatro escenarios de futuro. El artículo concluye con unas reflexiones sobre cómo se podría garantizar que las estrategias y los marcos políticos establecidos hoy por la AMB sean resilientes y adaptativos ante las diferentes direcciones potenciales que podrían tomar los procesos de transformación digital a escala local.

El contexto: la regulación europea de la IA y su impacto en los gobiernos locales

Después de años de negociaciones, el 13 de junio de 2024, la Unión Europea (UE) aprobó el Reglamento europeo de inteligencia artificial (AI Act), que establece unas normas en la materia armonizadas a escala europea. La característica principal de esta normativa es que pretende establecer una regulación integral de la IA en todo el territorio europeo, con el objetivo de garantizar que los sistemas de IA se desarrollen y se utilicen de una manera responsable. Para hacerlo, adopta un enfoque basado en riesgos: se prohíben aquellos usos que generan un riesgo inaceptable porque son susceptibles de violar derechos fundamentales (como algunos sistemas de categorización biométrica, sistemas de manipulación cognitiva conductual, o sistemas de puntuación social), y se regulan aquellos que comportan un riesgo elevado (como las infraestructuras críticas de transporte) o limitado (como los chatbots). En cuanto a los modelos de IA de uso general, como por ejemplo ChatGPT, la AI Act tiene en cuenta los riesgos sistémicos que podrían derivarse de su uso masivo.

Este reglamento europeo genera nuevas obligaciones para un amplio abanico de actores, desde empresas y desarrolladores de tecnología, hasta gobiernos y entidades reguladoras, incluidas las administraciones locales. En concreto, a partir de ahora, los ayuntamientos deberán preocuparse de clasificar correctamente los sistemas de IA que utilicen o que tengan intención de utilizar, así como de identificar los riesgos que de su uso puedan derivarse. Asimismo, en el momento de licitar la adquisición de esta tecnología, será necesario que se aseguren de que los sistemas obtenidos sean conformes a esta y otras normativas europeas, como el Reglamento General de Protección de Datos (Almonacid, 2024)1. Hay que tener presente, además, que muchos de los sistemas algorítmicos utilizados por los gobiernos locales podrían ser clasificados como de alto riesgo o de riesgo limitado (Galceran-Vercher y Vidal, 2024). Son un ejemplo de ello los sistemas utilizados en la provisión de bienes y servicios públicos esenciales, los que se usan para evaluar la elegibilidad para determinadas ayudas sociales, o aquellos que se emplean para mejorar la gestión del tráfico y la movilidad urbana.

Por otro lado, la AI Act (art. 27) exige que, previamente a su despliegue, los sistemas de IA de alto riesgo sean sometidos a una evaluación sobre el impacto que su uso puede suponer para los derechos fundamentales. Esto implica que las administraciones locales tendrán que implantar auditorías sobre algunas aplicaciones, idealmente de manera recurrente, que tengan por objetivo evaluar no solo los algoritmos sino también los conjuntos de datos para detectar posibles sesgos de género, lengua, origen, etnia, creencias, edad, nivel de educación, discapacidades físicas, psíquicas, de salud o situación económica. Finalmente, la normativa europea impone algunas obligaciones referentes a la transparencia y la explicabilidad de los sistemas algorítmicos utilizados, especialmente cuando afectan a los derechos de los ciudadanos. Herramientas muy útiles en este sentido, y que gobiernos locales como los de Ámsterdam, Helsinki, Nantes o Lyon ya están implementando, son los registros públicos de algoritmos.

En definitiva, el Reglamento europeo de inteligencia artificial supone un desafío significativo para los gobiernos locales, que tendrán que adaptar sus procesos, políticas y estrategias para cumplir con las nuevas exigencias. En este sentido, una preocupación habitual es si podrán implementar este nuevo marco normativo, no por falta de voluntad sino de capacidad técnica. De hecho, una problemática generalizada en muchas administraciones locales es la falta de habilidades técnicas y conocimiento especializado, no solo en relación con el entramado complejo de normativas europeas, sino sobre el funcionamiento mismo de los sistemas basados en IA2. Así, pues, existe la necesidad imperiosa de fomentar la alfabetización –digital y específica en materia de IA–, tanto entre los empleados públicos, como entre la ciudadanía. Solo así se podrá aprovechar todo el potencial de la inteligencia artificial de manera responsable.

¿Cómo podemos preparar a las administraciones locales para el mañana? Identificación de incertidumbres y escenarios plausibles

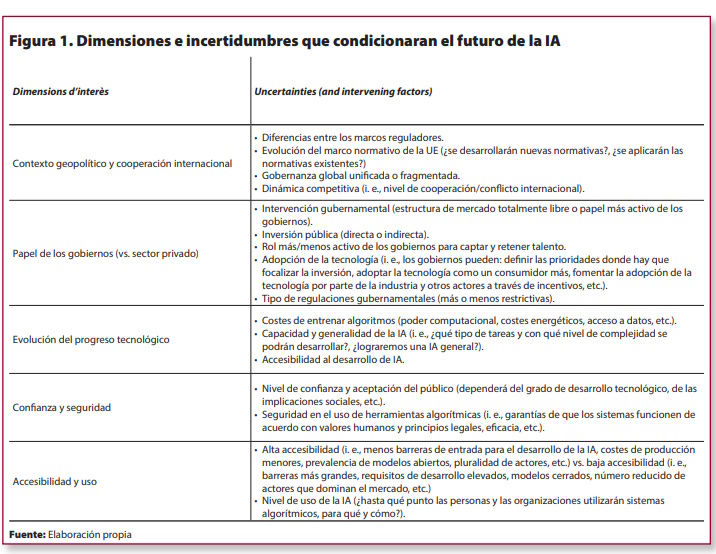

La inteligencia artificial es una tecnología de propósito general, característica que, junto con el hecho de que dispone de un número muy elevado de aplicaciones, genera muchas incertidumbres y dificulta cualquier ejercicio de prospectiva. Dichas incertidumbres no solo provienen del desarrollo de la tecnología en sí, sino también de la evolución del contexto político y socioeconómico en el que se inscribe su uso. Identificarlas, así como estimar el impacto potencial de su evolución sobre los gobiernos locales, nos puede permitir anticipar riesgos y oportunidades para mejorar la planificación estratégica y la elaboración de políticas públicas. A continuación, se presentan cinco dimensiones de interés, así como las incertidumbres que de ellas se pueden derivar y que potencialmente pueden tener un mayor impacto a corto-medio plazo sobre el despliegue y la gobernanza de sistemas algorítmicos a escala local.

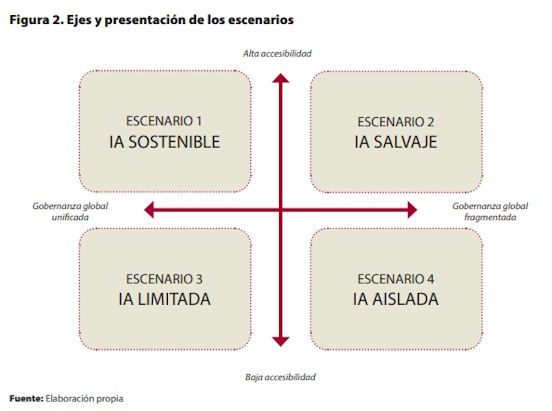

Teniendo en cuenta estos elementos, y a partir de la revisión de diferentes ejercicios de prospectiva llevados a cabo durante los últimos cuatro años (específicamente: PWC, 2020; United Kingdom Government Office for Science, 2023; Economist Impact, 2024; OECD, 2024), se han seleccionado dos ejes (la accesibilidad y el contexto geopolítico) que articulan la construcción de algunos escenarios plausibles sobre la gobernanza de la inteligencia artificial durante la próxima década.

Específicamente, se han dibujado cuatro futuros hipotéticos para la gobernanza de la IA en 2035: (1) IA Sostenible, (2) IA Salvaje, (3) IA Limitada, y (4) IA Aislada. Antes de entrar a describirlos, cabe resaltar que estos escenarios no son predicciones de futuro, sino que se han concebido como un instrumento de debate y de reflexión, donde se toman en consideración tanto elementos de gobernanza deseados como no deseados.

Escenario 1 – IA Sostenible

Existe un consenso global tanto alrededor de una serie de principios éticos como de estándares técnicos para el desarrollo de la inteligencia artificial. La UE ha jugado un papel influyente en la negociación de este marco de gobernanza global unificado, que ha acabado incorporando valores como la privacidad, la transparencia y la protección de derechos fundamentales básicos. La mayoría de gobiernos del mundo han adoptado un rol muy activo: proliferan las estrategias nacionales de IA, han aumentado significativamente los niveles de inversión pública, y se multiplican por doquier las iniciativas para promover un uso responsable de los sistemas algorítmicos. La existencia de marcos reguladores sólidos y, hasta cierto punto, restrictivos, ha comportado que se desarrollen menos aplicaciones de IA, pero que las que salen al mercado sean más seguras. Al mismo tiempo, esto ha mejorado la percepción pública de que los sistemas algorítmicos son seguros, y dichos mayores niveles de confianza se han traducido en unas altas tasas de demanda y de adopción de estas tecnologías. Por último, este escenario se produce en un contexto de alta accesibilidad a la creación y al uso de sistemas algorítmicos, que se explica por la preferencia dentro del ecosistema de desarrolladores (y de la industria) por modelos de código abierto.

Escenario 2 – IA Salvaje

Han fracasado todos los intentos de la última década para buscar un consenso global sobre principios éticos básicos o estándares de armonización técnica para el desarrollo de sistemas de IA. Por lo tanto, este es un mundo donde conviven múltiples marcos políticos heterogéneos, con diferentes niveles de madurez y que comportan diferentes grados de responsabilidad y de obligaciones. Asimismo, se han formado varios bloques reguladores de IA entre países con valores compartidos. Un número reducido de gobiernos nacionales se ha dotado de regulaciones y estrategias nacionales de IA, y hay cierta inversión pública, pero el rol de los gobiernos en el desarrollo de sistemas algorítmicos es muy modesto, y son la industria y las grandes corporaciones tecnológicas quienes están protagonizando el desarrollo y la regulación de esta tecnología disruptiva. Además, en este escenario, las regulaciones que se promueven desde los diferentes niveles de gobierno son mucho menos estrictas: en algunos casos incluso se flexibiliza la interpretación de las leyes de privacidad de datos para facilitar la innovación y la experimentación. La fragmentación normativa permite que las empresas y las startups más pequeñas exploten nichos de mercado, y existe cierta prevalencia de los modelos de código abierto. Este entorno de alta accesibilidad a la tecnología sin un marco político unificado, y un enfoque regulador poco estricto, comportan una proliferación incontrolada de sistemas de inteligencia artificial para ejecutar prácticas moralmente cuestionables como por ejemplo la manipulación de comportamiento. Asimismo, a los actores maliciosos les resulta muy fácil acceder a sistemas de IA muy potentes, hecho que aumenta el riesgo de accidentes, de ciberataques, y de proliferación de crisis de deepfakes. Esta sensación de inseguridad y de descontrol hace bajar los niveles de confianza y seguridad en los sistemas algorítmicos, y esto se traduce en un uso moderado por parte de organizaciones y de la población en general.

Escenario 3 – IA Limitada

Existe cierto consenso global para el establecimiento de estándares técnicos también globales para el desarrollo de tecnologías de IA, pero no de principios éticos. Hay que hablar, por lo tanto, de un marco de gobernanza internacional moderadamente unificado. En este contexto, la UE tiene una influencia global muy limitada, y son China y Estados Unidos los que dominan el mercado mundial. Existen algunas regulaciones nacionales, pero mayoritariamente son muy laxas. Los niveles de inversión pública en el desarrollo de sistemas de la IA son muy bajos, y este es liderado, en esencia, por la industria. Prevalecen los modelos de código cerrado, y la participación de empresas pequeñas y medianas en el mercado es muy limitada. Esto se explica, sobre todo, por los altos costes asociados al desarrollo de sistemas algorítmicos, así como por las dificultades de cumplir con marcos reguladores fragmentados (solo las grandes multinacionales se lo pueden permitir), y la falta de inversión pública. En este escenario, el grado de confianza y de aceptación pública del uso de sistemas algorítmicos es muy moderado, hecho que comporta unos niveles de adopción relativamente bajos por parte de organizaciones y de individuos.

Escenario 4 – IA Aislada

No se ha conseguido alcanzar un consenso para promover un marco de gobernanza global unificado de la IA, y, por lo tanto, existe un mosaico fragmentado de iniciativas y modelos reguladores. Esta situación también se produce en la UE, donde no se ha conseguido implementar de manera satisfactoria la regulación europea de inteligencia artificial (EU AI Act), de modo que se da un contexto de alta fragmentación reguladora, que está comportando numerosos problemas derivados de la escalabilidad limitada de los sistemas de IA. En este escenario, los gobiernos locales juegan un papel más bien limitado: ni regulan, ni invierten en el desarrollo de dichos sistemas. Por el contrario, es la industria quien promueve iniciativas de autorregulación voluntaria, y es también quien decide qué aplicaciones desarrolla; algo que lleva a cabo, sin embargo, siguiendo criterios comerciales, que no necesariamente tienen en cuenta los beneficios (o los perjuicios) sociales. Se produce un entorno de baja accesibilidad al desarrollo y uso de sistemas algorítmicos, que se explica por un contexto de gobernanza complejo y fragmentado, que dificulta la escalabilidad de muchos productos de IA a varios contextos, excepto para las empresas grandes y con mejores recursos. Esto acaba repercutiendo en unos niveles muy bajos de adopción: existe un ecosistema de datos balcanizado, que comporta una IA con un rendimiento limitado y de baja calidad. Asimismo, acaban llegando al mercado muchos productos defectuosos y poco seguros, cosa que hace bajar los niveles de confianza y de uso de los sistemas algorítmicos de diversas organizaciones.

Riesgos, oportunidades y escenarios de futuro deseables

Como se ha apuntado anteriormente, la elaboración de escenarios se concibe como un instrumento no de predicción de futuro, sino de debate y de reflexión. Específicamente, en el ejercicio llevado a cabo en el marco del seminario se ha buscado dar respuesta a tres preguntas fundamentales: (1) ¿qué futuros podrían ser más deseables que otros?; (2) ¿qué riesgos y oportunidades se espera que puedan materializarse en cada uno de estos escenarios desde la perspectiva de los gobiernos locales?; (3) ¿cómo se podrían gestionar los riesgos asociados a cada uno de estos escenarios? En definitiva, se trata de reflexionar sobre cómo, en un contexto marcado por numerosas incertidumbres, los gobiernos locales pueden garantizar una supervisión democrática de los sistemas algorítmicos utilizados.

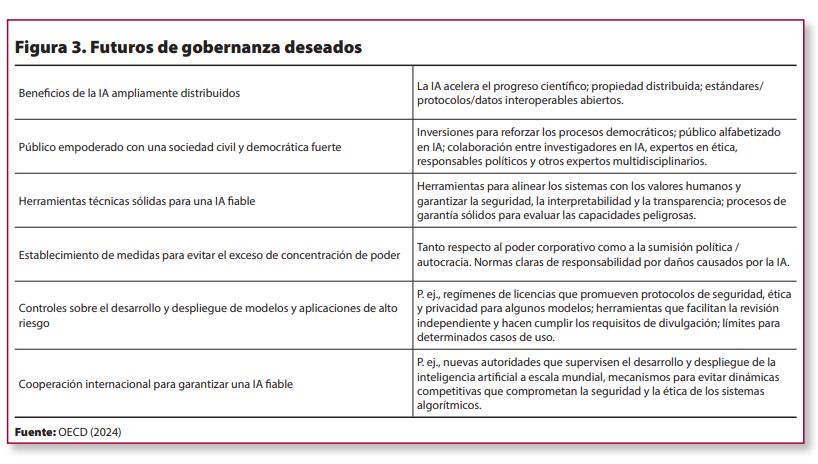

Empezando por la primera cuestión, relativa a los futuros deseables, se podría argumentar que el escenario de la IA sostenible es el que tal vez reúne más elementos que podrían ser favorables a un despliegue responsable de sistemas algorítmicos a escala local y metropolitana. A continuación se resumen estos elementos, que podrían ser tenidos en consideración en los procesos de reflexión estratégica y de incidencia política que se puedan impulsar desde la AMB.

Más allá de la identificación de los futuros deseables, del análisis de los diferentes contextos que dibujan los cuatro escenarios planteados se derivan una serie de implicaciones para los gobiernos locales. Por ejemplo, es plausible pensar que, en un contexto donde existe cierto consenso global en torno a los principios éticos y/o los estándares técnicos que deben guiar el desarrollo de la inteligencia artificial, sea más fácil generar marcos reguladores sólidos y mejorar la aceptación general de los sistemas algorítmicos. Esto podría permitir que los gobiernos locales desarrollaran y desplegaran soluciones basadas en la IA para la gestión urbana de manera más segura, sin chocar con las reticencias de la ciudadanía.

En este escenario, las administraciones públicas (también las locales) tendrán que establecer marcos viables para las certificaciones, las auditorías y los controles que tienen que garantizar el cumplimiento de las diferentes normativas. Por lo tanto, habrá que asignar recursos para reforzar el ecosistema (nacional, regional y local) de la IA, así como mejorar la capacidad técnica de los responsables de las agencias gubernamentales directa o indirectamente implicados en el despliegue de sistemas algorítmicos. Además, es posible que este sea un contexto proclive al aumento de programas de financiación y capacitación técnica hacia los gobiernos locales para que puedan asumir las responsabilidades que les correspondan, pero también a la proliferación de colaboraciones con el sector privado y las universidades.

Por el contrario, en un contexto de gobernanza global fragmentada y de proliferación incontrolada de sistemas algorítmicos, posiblemente, los gobiernos tendrán que idear estrategias para integrar los esfuerzos de desarrollo de la IA en un entorno más inestable e incierto. Para hacerlo, harán falta enfoques flexibles y adaptativos, con el objetivo de reducir las complejidades reguladoras innecesarias. Por otro lado, previsiblemente, aumentarán los ciberataques, y los municipios (en especial los pequeños o los medianos) no siempre estarán preparados para afrontarlos. Asimismo, este es el escenario que plantea más retos de cara a la protección de los datos y de los derechos digitales de la ciudadanía, algo que acentuará la necesidad de promover marcos locales de gobernanza de la IA alineados con valores democráticos.

Por último, podríamos pensar que un contexto de alta accesibilidad posiblemente facilitaría la proliferación de desarrolladores más pequeños, también locales, que podrían adaptar los sistemas algorítmicos a las necesidades específicas de cada municipio. Por el contrario, en aquellos escenarios caracterizados por el dominio de las grandes multinacionales en el mercado de productos de IA, los gobiernos locales tendrían una menor capacidad para adquirir productos personalizados, adecuados a su contexto específico.

¿Cómo garantizar una supervisión democrática de los sistemas algorítmicos y una distribución satisfactoria de los beneficios de la IA?

Existe un consenso generalizado en cuanto a la exigencia inaplazable de reformar el actual modelo de administración pública, para hacerla más eficiente, transparente y centrada en las necesidades de la ciudadanía. La creciente accesibilidad de tecnologías revolucionarias como la IA abre nuevas oportunidades para avanzar en esta dirección, pero solo si los procesos de digitalización van acompañados de las medidas necesarias para transformar también las lógicas de funcionamiento de la administración. En otras palabras, no solo hay que digitalizar, sino que también hay que transformar. Ante el auge y la popularidad que han adquirido las tecnologías de inteligencia artificial, muchos gobiernos locales tienen que gestionar dos realidades que a menudo conviven dentro de una misma organización: por un lado, el optimismo desmesurado en las potencialidades de los sistemas algorítmicos para resolverlo todo; por otro, los discursos apocalípticos sobre los riesgos asociados con el uso de estas tecnologías, que pueden frenar su adopción.

En este contexto, resulta más pertinente que nunca intentar dar respuestas a la cuestión de cómo garantizar una supervisión democrática de los sistemas algorítmicos que asegure una distribución satisfactoria de los beneficios asociados con el uso de la IA por parte de las administraciones locales. Una primera propuesta en esta dirección es desplazar el debate sobre si hay que regular o no, y focalizarlo, por un lado, en contar con buenas regulaciones y, por otro, en asegurar la implementación efectiva de las que ya tenemos. Por ejemplo, no había que esperar a tener la AI Act para prohibir los sistemas de puntuación social, porque otras normativas europeas como el Reglamento General de Protección de Datos ya impedían este tipo de prácticas. Por el contrario, varios expertos han avisado reiteradamente de que algunas exigencias de las normativas europeas solo las podrán aplicar las grandes corporaciones, no las empresas pequeñas y medianas. Esta misma reflexión podría ser extrapolable a los gobiernos locales: tener regulaciones con un nivel de exigencia muy elevado puede comportar un alto porcentaje de incumplimiento. De hecho, en algunos casos, incluso, podría ser deseable que la administración pública pudiera asumir los riesgos razonables que todo proceso de transformación digital comporta.

Por otro lado, para garantizar la implementación efectiva de las normativas europeas, nacionales y regionales es importante tener organismos reguladores —como el Centro Europeo por la Transparencia Algorítmica (ECAT) o la Agencia Nacional de Supervisión de la Inteligencia Artificial— que funcionen con todo su potencial. También sería deseable que pudieran ofrecer asistencia técnica y orientaciones prácticas diseñadas específicamente para gobiernos locales. En este sentido, hay que dotar a las administraciones locales de más herramientas prácticas que garanticen un uso responsable de los sistemas algorítmicos. Por ejemplo, muchos organismos tienen estrategias de gobernanza sobre la IA, pero todavía son pocas las administraciones locales que hayan implantado registros públicos de algoritmos o que lleven a cabo evaluaciones éticas de datos y sistemas de inteligencia artificial3.

Finalmente, hay que invertir esfuerzos en las acciones de pedagogía y sensibilización orientadas a mejorar la comprensión general de la IA y su impacto, tanto entre los equipos humanos municipales como entre la ciudadanía, así como fomentar iniciativas que aseguren su participación en el despliegue seguro y ético de los sistemas algorítmicos. Cabe señalar que estas acciones no necesariamente las debe llevar a cabo la administración pública, puesto que a menudo no tiene las herramientas ni el conocimiento imprescindibles. Por el contrario, podría ser mucho más efectivo favorecer alianzas con organizaciones como Xnet o CIVICAi, con una trayectoria acreditada en la defensa de los derechos digitales, cuya protección es más importante que nunca sea cual sea el futuro de la IA hacia el que acabemos avanzando.

Referencias bibliográficas

Almonacid, V. (2024). «Reglamento (europeo) de Inteligencia Artificial: impacto y obligaciones que genera en los Ayuntamientos». El Consultor de los Ayuntamientos, 15 de julio de 2024, LA LEY. Diario LA LEY, n.º 10553, Sección Tribuna, 24 de julio de 2024, LA LEY.

Ben Dhaou, S.; Isagah, T.; Distor, C. y Ruas, I. C. (2024). Global assessment of Responsible Artificial Intelligence in cities: Research and recommendations to leverage AI for people-centred smart cities. Nairobi, Kenya. United Nations Human Settlements Programme (UN-Habitat).

Economist Impact (2024). AI landscapes: Exploring future scenarios of AI through to 2030. London: Economist impact (en línea) [fecha de consulta: 30.11.2024] https://impact.economist.com/projects/what-next-for-ai/ai-landscapes/

Galceran-Vercher, M. y Vidal, A. (2024). «Mapeo de la inteligencia artificial urbana: primer informe del Atlas de Inteligencia Artificial Urbana del GOUAI». CIDOB Briefings, n.º56.

OECD (2024). «Assessing potential future artificial intelligence risks, benefits and policy imperatives». OECD Artificial Intelligence Papers, núm. 27 (noviembre de 2024).

PWC (2020). The many futures of Artificial Intelligence: Scenarios of what AI could look like in the EU by 2025. Marzo de 2020.

United Kingdom Government Office for Science (2023). «Future Risks of Frontier A: Which capabilities and risks could emerge at the cutting edge of AI in the future?». Department for Science, Innovation and Technology. Government of the United Kingdom (octubre de 2023) (en línea) [fecha de consulta: 30.11.2024] https://assets.publishing.service.gov.uk/media/653bc393d10f3500139a6ac5/future-risks-of-frontier-ai-annex-a.pdf

Notas:

1- La AI Act es una normativa hermana del Reglamento General de Protección de Datos (RGPD) de mayo de 2018, pues no hay inteligencia artificial sin datos.

2- Un estudio reciente apunta que hasta un 20% de los directores tecnológicos y más del 55% de los trabajadores municipales de una muestra de 122 ciudades de todo el mundo están desarrollando proyectos de IA sin los conocimientos y la experiencia previa necesarios (Dhaou et al., 2024).

3- El modelo de autoevaluación PIO (Principios, Indicadores y Observables), diseñado por el Observatorio de Ética en Inteligencia Artificial de Cataluña (OEIAC), podría ser fácilmente implementado en muchas administraciones locales, por ejemplo.

Todas las publicaciones expresan las opiniones de sus autores/as y no reflejan necesariamente los puntos de vista de CIDOB como institución