La regulación europea de la IA ante los sesgos y riesgos de discriminación algorítmica en contextos migratorios

Encarnación La Spina, profesora contratada doctora encargada, Facultad de derecho, Universidad de Deusto (Bilbao). elaspina@deusto.es. ORCID: https://orcid.org/0000-0003-0423-0674

La creciente institucionalización de la inteligencia artificial (IA) es un problema social especialmente preocupante para aquellos colectivos más vulnerables, como pueden ser las personas migrantes y solicitantes de asilo. Si bien los contextos migratorios globales están siendo objeto de un férreo control securitario y de una amplia transformación digital, la regulación europea sobre la IA presenta todavía un alcance muy limitado para contrarrestar las repercusiones negativas del diseño y entrenamiento de algoritmos. A tal propósito, este artículo plantea una revisión crítica sobre cómo se introducen los sistemas de IA en el control y la gestión migratorios europeos y analiza por qué el nuevo marco regulador de la IA es insuficiente para evitar el impacto discriminatorio de sesgos, estereotipos y riesgos asociados a las dinámicas asimétricas de poder y a las estructuras de injusticia social subyacentes a las migraciones.

Un primer abordaje sobre el trabajo de la Unión Europea (UE) referente a la regulación de la inteligencia artificial (IA), requiere entender qué es la IA y qué comprende un sistema de IA; sin embargo, no existe un consenso general sobre su definición (Ruiz Tarrías, 2023: 95). Entre las varias descripciones técnicas posibles, aquellas más extendidas, si bien con significaciones muy diferentes, sostienen que la IA se refiere a un conjunto de tecnologías que utilizan datos combinados y aplican modelos o algoritmos, junto con el poder de cómputo proporcionado por las Tecnologías de la Información (TI), para procesar y generar información de manera eficiente a partir de gran cantidad de datos de entrada o salida. Su finalidad principal es obtener con cierto grado de autonomía y precisión, resultados sólidos, como son predicciones, contenidos, recomendaciones o decisiones que pueden influir en entornos físicos o virtuales más o menos concretos que requerirían, por lo general, la inteligencia humana para completarse satisfactoriamente (Zuiderveen Borgesius, 2018; FRA, 2022). Precisamente, dada la capacidad de inferencia y el alcance de la IA frente a softwares, hardwares o programaciones tradicionales, la UE trabaja desde hace años en una regulación de la IA que sea pionera a escala global, multisectorial y transversal, tanto en el plano institucional como social (Ruiz Tarrías, 2023: 92).

Uno de los ámbitos de acción prioritaria de la agenda europea con potencial impacto de la IA es la gestión de los flujos migratorios de llegada, el control y la externalización de las fronteras en países de origen y tránsito, la verificación de la identidad, así como la atribución del estatuto de residencia, sin perjuicio de los procesos de determinación del asilo o de acogida e integración. En este amplio ámbito competencial, el uso de tecnologías basadas en sistemas de IA –una de las herramientas de transformación digital más potente y de rápida evolución– ya está prácticamente generalizado y casi plenamente operativo a escala europea (EMN, 2022: 11; Okzul, 2023: 64 y 40); al igual que en Canadá, Australia, China y Estados Unidos (Akhmetova, 2020; Nalbandian, 2022; Molnar, 2024). En la UE, el uso progresivo de la IA es ya una realidad en estados miembros pioneros como Alemania, Finlandia, Hungría, Grecia, Letonia, Lituania y los Países Bajos1, pero también en diferentes agencias europeas como la Agencia para la Gestión Operativa de Sistemas Informáticos de Gran Magnitud en el Espacio de Libertad Seguridad y Justicia (eu-LISA), la Agencia de Asilo de la UE (AAUE), la Agencia de la Guardia de Fronteras y Costas de la UE (Frontex), así como en otras organizaciones internacionales, como ACNUR el Comité de Rescate Internacional (IRC, por sus siglas en inglés) y la Organización Internacional para las Migraciones (OIM), que se sirven de la IA para gestionar una gobernanza migratoria más eficiente, neutral y objetiva (Marin, 2011: 145; Leese, 2014: 495).

Ahora bien, este avance exponencial de la IA no sintoniza con el ritmo de transformación lento que marca el Reglamento de IA de la UE del 13 de junio de 20242. Es más, con su escalonada entrada en vigor a partir de 2026, se confirma como objetivo prioritario apostar por un uso fiable de la IA y, en menor medida, prohibir todos los posibles impactos negativos asociados a la aplicación de estos sistemas de software inteligente. Por ello, aunque la entidad de los múltiples riesgos asociados a la discriminación algorítmica es ya de sobra conocida y advertida (Chander, 2017), su presunta inocuidad, exactitud u objetividad son cada vez más cuestionadas por la doctrina. Por ejemplo, por quienes sostienen su posible incompatibilidad prima facie en términos de protección de datos y privacidad y, en segunda instancia, por los que alertan de su inevitable impacto discriminatorio en función de sus posibles fines y datos, personas o grupos afectados y contextos de aplicación. Precisamente, el difícil equilibrio entre el carácter no discriminatorio y la transparencia de los sistemas de IA (EDRi, 2022) vaticina una futura tendencia regresiva y menos garantista hacia la protección de los derechos humanos en la UE, especialmente para ciertas personas o grupos vulnerables (Avello, 2023; Garrido Carillo, 2023).

Por esta razón, se ha empezado a estudiar no solo cómo se diseñan, desarrollan e implementan los diferentes sistemas de IA de externalización y control fronterizo (Leese et al., 2022; Napolitano, 2023: 7-8) –aquellos usados en ciclos migratorios de tránsito y destino para la acogida extraordinaria u ordinaria (Beduschi, 2022; Leese, 2014)–, sino que también se ha puesto el foco sobre los desafíos ético-jurídicos inherentes a la IA (FRA, 2022; Moreno, 2021; Cruz, 2020 Vavoula, 2021). En particular, estos desafíos son evidentes en los contextos fronterizos y en la gestión migratoria de entrada/salida/estancia (Beduschi, 2021; Molnar, 2023), al convertirse en el mayor laboratorio de datos a gran escala que existe para el diseño de software algorítmico y para la progresiva experimentación de sistemas de IA (EC, 2011, 2016, 2021a, 2021b y 2021c). Y ello porque, básicamente, estos sistemas parecen abocados a tolerar sine die dinámicas asimétricas de poder sobre los cuerpos migrantes, lo que ya ha demostrado ser altamente discriminatorio y sesgado, sobre todo contra grupos racializados y marginados sin libertad de decisión o autonomía migratoria, por no mencionar que aquellos son culturalmente insensibles a la diversidad (Molnar, 2019; Forti, 2024; Romano, 2023).

A fin de analizar este fenómeno, este artículo plantea, en primer lugar, una retrospectiva que examina cómo se ha producido la transformación digital en los sistemas de información europeos a gran escala que operan en el ámbito migratorio, incluyendo especialmente un mapeo de los proyectos financiados por la UE que ya incluyen tecnología IA en ciertos países; y, en segundo lugar, al hilo del Reglamento de IA de la UE, se identifica y se valora cómo se regulan en este nuevo marco normativo los factores de discriminación algorítmica y cómo se controlan los sesgos asociados al uso de tales sistemas de IA en contextos migratorios.

La transformación digital y el uso de la IA en el ámbito migratorio europeo

Desde la puesta en marcha del Espacio de Libertad, Seguridad y Justicia (ELSJ; Tratado de Ámsterdam, 1999), la UE ha mantenido, pese a un desarrollo normativo y programático cambiante, una línea continuista de carácter securitario sobre la migración y el asilo. Una muestra de esta creciente deriva y apuesta por la seguridad ha sido la paulatina aplicación de diferentes dispositivos tecnológicos y biométricos basados en sistemas de IA capaces de mejorar el monitoreo, así como la eficiencia de los procesos y las prácticas de securitización, externalización y criminalización en la UE (art. 3.2 TUE y art. 67 y 77 TFUE). De este modo, el ELSJ, por medio de la transformación digital de estas prácticas, especialmente en las fronteras exteriores, se ha convertido en un complejo ecosistema tecnológico, digital e inteligente gracias al desarrollo actual de la gestión integrada y a la interoperabilidad de los diferentes sistemas de información a gran escala (Broeders, 2007; Vavoula, 2021), así como al progresivo uso aplicado de la IA en el marco de proyectos financiados con fondos europeos.

Principales hitos en la transformación digital de la gestión integrada de los sistemas de información a gran escala

El objetivo de reforzar los sistemas de información, la arquitectura de datos y el intercambio de información en los ámbitos de la gestión de las fronteras y la lucha contra el terrorismo ha sido determinante para consolidar el proceso de transformación digital europeo. Sin duda, un primer hito de este proceso se materializó en 2022 con la última actualización del Sistema de Información Schengen (SIS), con el SIS II3 que, pese a limitar el acceso a los datos estrictamente necesarios para determinadas autoridades en cumplimiento de su misión (Cruz Ángeles, 2022: 94-104), incluye el acceso a datos biométricos (huellas palmares, imágenes faciales y perfiles de ADN relacionados con personas desaparecidas o con infracciones penales) a efectos de denegación de entrada o de estancia en el espacio Schengen.

En paralelo, un segundo hito ha sido la reciente reforma de la base de datos de dactiloscopia de solicitantes de asilo (EURODAC)4, un sistema de determinación del país responsable del examen de las solicitudes de protección internacional, pero que también permite el acceso policial para prevenir, detectar e investigar delitos de terrorismo y otros delitos graves. Con su entrada en vigor en 2026, será posible incluir la recogida de datos alfanuméricos de identidad que permitan el recuento de personas solicitantes de asilo (no solo de solicitudes); la inclusión de nuevas categorías de personas (aquellas desembarcadas tras operaciones de búsqueda y rescate para un control preliminar en frontera); el tratamiento de nuevos datos biométricos (imagen facial y ADN); así como la reducción de la edad para la toma de huellas dactilares (de los 12 a los 6 años).

Como tercer hito más próximo a un proceso avanzado de securitización tecnológica (Oliveira y Gabrielsen, 2022: 1443), cabe mencionar la reciente reforma del Sistema de Información de Visados (SIV)5. En concreto, esta reforma ha permitido ampliar su ámbito de aplicación (incluir datos sobre visados de larga duración y permisos de residencia) y mejorar los controles en la tramitación de visados (entre otros, con la comprobación de antecedentes para identificar riesgos), dado que, en determinadas condiciones, las autoridades nacionales y Europol pueden acceder a los datos del SIV con fines de prevención, detección e investigación de delitos terroristas y penales.

Asimismo, desde 2019 y dentro del proceso de transformación digital, cabe señalar un cuarto hito con la creación de otros tres nuevos sistemas (EES, ETIAS y ECRIS-TCN, por sus siglas en inglés). El primero, el Sistema de Entradas y Salidas (EES)6, fue establecido en 2017 para registrar digitalmente la entrada y salida (y la denegación de entrada) de los titulares de visados de corta duración y de los viajeros exentos de visado que crucen las fronteras exteriores de la UE. Este sistema calcula automáticamente la duración de la estancia autorizada de una persona y genera alertas a los estados miembros cuando la estancia autorizada haya expirado; además, las autoridades policiales y Europol podrán acceder al EES para prevenir, detectar e investigar delitos de terrorismo u otros delitos graves. El segundo, el Sistema Europeo de Información y Autorización de Viajes (ETIAS)7, implementado en 2018, preregistra a los visitantes exentos de visado que viajan al espacio Schengen y así evalúa los riesgos de seguridad o de migración irregular que plantean estas personas antes de que lleguen a la frontera por medio de una lista de vigilancia de personas sospechosas. Y, el tercero, el Sistema Europeo de Información de Antecedentes Penales de Nacionales de Terceros Países (ECRIS-TCN) creado en 20198, permite saber qué otros estados miembros poseen antecedentes penales de nacionales de terceros países o apátridas, o de ciudadanos de la UE que también posean la nacionalidad de un tercer país.

Por último, como quinto hito, se añade el desarrollo y la revisión de un marco de interoperabilidad (EC, 2016) regulado en el ámbito de los Reglamentos 2019/817 y 2019/8189 que incluye la puesta en marcha de cuatro componentes cruzados: el Portal Europeo de Búsqueda (PES, por sus siglas en inglés), el Servicio Compartido de Correspondencias Biométricas (BMS, por sus siglas en inglés), el Repositorio Común de Identidades (CIR, por sus siglas en inglés) y el Detector de Identidades Múltiples (MID, por sus siglas en inglés) (Dumbrava, 2021: 17; Cruz Ángeles, 2022).

La aplicación de la IA en los proyectos europeos financiados para la gestión y control de los flujos migratorios

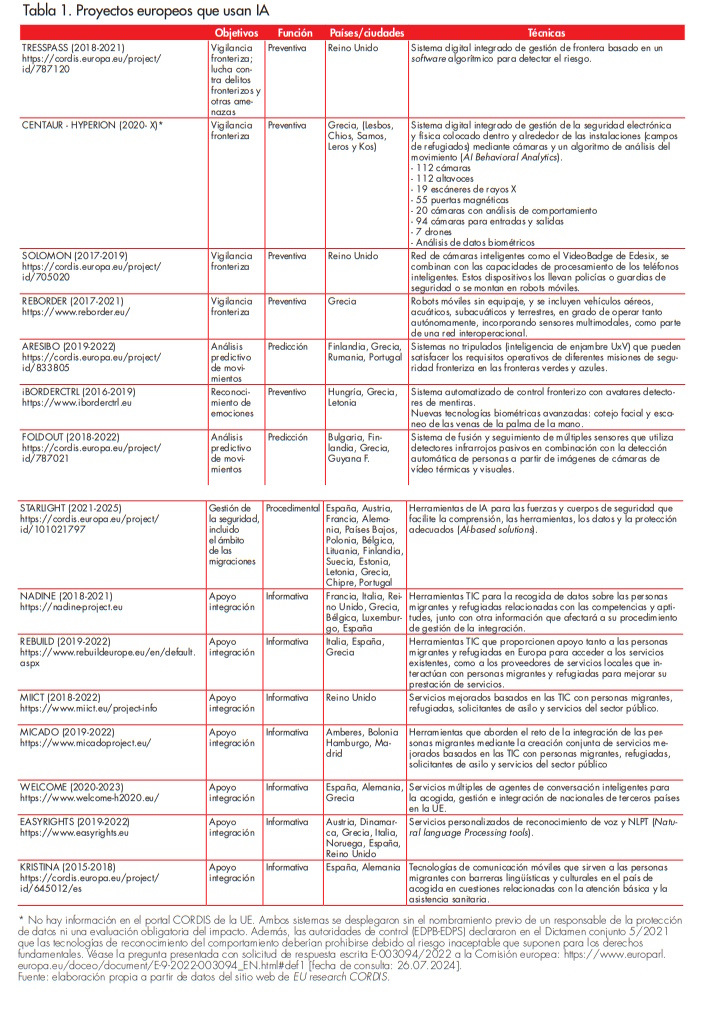

Una vez alcanzada la plena interoperabilidad de los mencionados sistemas en 2025, y pese a las críticas vertidas sobre el proceso algorítmico del ETIAS (Guild y Vavoula, 2020; Derave et al., 2022), la irrupción de sistemas de IA es cada vez más tangible en la UE. Precisamente, la financiación pública que reciben numerosos proyectos a escala europea (Kilpatrick y Jones, 2022: 31-46) ha hecho posible incorporar técnicas de aprendizaje-máquina que generan contenidos, predicciones, recomendaciones o decisiones con capacidad de inferencia en el entorno con el que el sistema interactúa. Por ejemplo, a día de hoy, ya se ha testado y desarrollado IA con software algorítmico aplicable al control de flujos migratorios, la evaluación automatizada de riesgos, la predicción por medio de polígrafos y vigilancia por drones, cámaras termográficas, sensores de movimiento y térmicos o bien los sistemas de identificación y categorización biométrica en remoto, la captación y reconocimiento de imágenes faciales, emociones, idiomas o la recopilación automática de huellas dactilares u otros datos personales (Burgess y Klotza, 2021; Musco, 2023: 25).

Tal y como se recoge en la tabla 1, no solo hay variedad de técnicas de IA en función del grado de eficiencia de los objetivos perseguidos (prever la movilidad humana o predecir la demanda futura en los sistemas nacionales de asilo, informar de las operaciones de control fronterizo o coordinar ayuda humanitaria), sino que también se puede observar el cumplimiento de diferentes funciones (Loddo y Addis, 2023). Entre otras, destacan las funciones predictivas o constrictivas y preventivas en el control fronterizo frente a las funciones informativas o procedimentales en la gestión migratoria.

Por último, también existen distintos informes (EMN, 2022; EC, 2020a y 2021b) que recogen evidencias de otros usos aplicados de la IA desde administraciones públicas y ONG. Por ejemplo, chatbots10, asistentes virtuales o interactivos de voz, software algorítmico para la logística de centros de acogida o programas de integración11. Todos ellos, conforme al marco normativo vigente, deberían cumplir con salvaguardias éticas, obligaciones de transparencia o reducción de riesgos dado el volumen de características y datos personales (edad, sexo, tamaño de la familia, idioma, vulnerabilidades) que almacenan, manejan o acceden antes del proceso de entrada y durante la estancia en la UE.

El Reglamento de IA de la UE ante el uso de la IA en el contexto migratorio europeo

Frente a la funcionalidad y versatilidad de los mencionados sistemas basados en IA en el ámbito migratorio, los modelos regulatorios de la IA han quedado absortos por una amplia e infructuosa discusión sobre tres diferentes opciones: autorregulación, hiperregulación y lassez faire (Ruiz Tarrías, 2023: 93). Siguiendo un enfoque equilibrado entre derechos y beneficios para una plena «soberanía europea digital», la legislación europea en materia de IA ha sido sometida a una ardua negociación para construir y permitir de facto un modelo de vigilancia regulatoria casi abstencionista (ibídem: 115), habida cuenta de las limitadas prohibiciones y las excepciones vigentes en contextos migratorios (EDRI, 2022). Así pues, actualmente, el Reglamento de IA de la UE configura como techo de cristal un «sistema de regulación de cinco niveles basado en el riesgo», que abarca desde la ausencia de regulación en el caso de los sistemas de IA más inocuos hasta la prohibición absoluta en el caso de los más peligrosos como, entre otros, las captaciones de rasgos de identidad automatizadas (art. 5.1).

Sin embargo, tal y como advierten las voces más críticas (Veale y Zuiderveen Borgesius, 2021), para grupos históricamente marginados y vulnerables como las personas migrantes es necesario calibrar el impacto discriminatorio de los algoritmos aplicados a tales sistemas, analizando tanto el anverso de este marco regulador como sus posibles reversos.

El anverso limitado del Reglamento de IA en materia de migración, asilo y control fronterizo

El Reglamento de IA inscribe la migración, el asilo y el control fronterizo dentro de las áreas de alto riesgo para los derechos fundamentales, y recoge obligaciones de transparencia y comunicación de información a los usuarios (art. 13), así como la necesidad de vigilancia humana (art. 14). Sin embargo, de un lado, limita su ámbito de aplicación a las personas migrantes afectadas que estén ubicadas en la UE (art. 2.1 g), es decir, obvia las «ficciones de no entrada» previstas en el Reglamento de triaje (screening)12, y excluye los proyectos de investigación y desarrollo científico (véase tabla 1) que no se hayan introducido al mercado (art. 2.6); y, de otro lado, no contempla por ahora la prohibición absoluta de evaluación de indicadores de riesgos, ni tampoco se prevé la necesidad de auditorías externas de sistemas de IA para poder detectar y corregir posibles sesgos discriminatorios «de origen racial o étnico» (UN, 2020; EDRI, 2022). Esta aseveración se deriva del artículo 5 donde se recoge un elenco de prácticas prohibidas (total o parcialmente matizadas) y riesgos inaceptables, pero al mismo tiempo se mantienen vía el artículo 6.2 amplias excepciones respecto a la necesidad de autorización previa (art. 5.3), el requisito de doble verificación (art. 14.5) y la confidencialidad de la información intercambiada (art. 58.3; art. 59.1 f), que reducen a mínimos el alcance de lo prohibido frente a lo tolerado y permitido en los sistemas de IA de alto riesgo del Anexo iii apartado 7.

En concreto, figurarían como prohibidos (art. 5.1), en primer lugar, los sistemas de IA que se sirvan de técnicas subliminales que trasciendan la conciencia humana para alterar de manera sustancial su comportamiento de un modo que provoque incluso de forma probable perjuicios físicos o psicológicos a esa persona u otra. En segundo lugar, sistemas de IA que aprovechen alguna de las vulnerabilidades de un grupo específico de personas debido a su edad o discapacidad física o mental para alterar de manera sustancial el comportamiento de una persona que pertenezca a dicho grupo de un modo que provoque incluso de forma probable perjuicios físicos o psicológicos a esa persona u otra. En tercer lugar, sistemas de IA usados por parte de las autoridades públicas con el fin de evaluar o clasificar la fiabilidad de personas físicas durante un período determinado de tiempo atendiendo a su conducta social o económica, a características personales o de su personalidad conocidas que provoquen: un trato perjudicial o desfavorable hacia determinadas personas físicas o colectivos enteros y que este sea injustificado o desproporcionado. Y, por último, la utilización de sistemas de identificación biométrica remota «en tiempo real» en espacios de acceso público con fines policiales, salvo que sea estrictamente necesario para búsqueda de posibles víctimas, prevención de amenazas a la seguridad, o búsqueda de posible perpetrador o sospechoso.

Si se hace una triangulación entre las mencionadas herramientas IA recogidas en los proyectos ya implementados en la UE, todas ellas integrables en el Anexo iii 1, 6 y 7, y este catálogo general de prohibiciones, se erigen importantes salvedades, gracias a la eficacia de los usos y fines de aquellas prácticas que devienen legales conforme con el derecho nacional y de la UE (considerando 30 y art. 6.3). Por ejemplo, sería el caso de los proyectos que cumplen una función predictiva como iBORDERCTRL, para detectar la credibilidad del estado emocional de una persona física, o proyectos que se sirven de herramientas predictivas (FOLDOUT o ARESIBO); así como la gran mayoría de aquellos que persiguen la función preventiva13 para evaluar determinados riesgos que presenten personas físicas que entren en el territorio de un Estado miembro o soliciten un visado o asilo; sin perjuicio de los desarrolladores algorítmicos previstos en los sistemas de información a gran escala (Anexo X), que permiten verificar la autenticidad de los documentos pertinentes de personas físicas o bien ayudan a las autoridades públicas competentes a examinar las solicitudes de asilo, visado y permiso de residencia, así como las reclamaciones conexas para determinar si las personas físicas solicitantes de asilo reúnen los requisitos necesarios para su obtención.

De este modo, la valencia de las prohibiciones y los usos admisibles parecen entrar en neta contradicción con la letra de los considerandos 6, 7 y 60 del Reglamento de IA de la UE, especialmente con su referencia a los valores y derechos europeos y los principios ius cogens de la protección del asilo. Básicamente porque, primero, desde la excepcionalidad se reconoce que tales sistemas mayoritarios, aun teniendo un vago soporte garantista (Romano, 2023: 240), sirven «para preservar la capacidad de las autoridades competentes (…)» (considerando 33), pero son y pueden ser invasivos al afectar significativamente la vida de personas migrantes que a menudo se encuentran en una posición especialmente vulnerable (considerando 30) o generar formas de discriminación no solo de origen racial o étnico (considerando 56). Y, segundo, porque las prohibiciones de alguno de ellos pueden modularse o justificarse por razones de eficiencia y oportunidad como «aliviar la carga administrativa y no retrasar la implementación de sistemas del Anexo X». Este es un desiderátum vacuo sobre la exactitud, el carácter no discriminatorio y la transparencia de los sistemas de IA utilizados, que atribuye a quiénes diseñan y controlan los sistemas de IA, una fiabilidad y autocontención técnica para garantizar el respeto de los derechos fundamentales de las personas o grupos vulnerables afectados, sin reforzar los mínimos exigibles en caso de advertirse un impacto discriminatorio directo o indirecto.

Por último, resulta contradictorio con la voluntad de impulsar «una tecnología centrada en el ser humano» que los sistemas de información ya introducidos en el mercado o puestos en servicio según el Anexo X (SIV, SIS, Eurodac, SES, SEIAV o ETIAS), queden excluidos de vigilancia regulatoria según el art. 11.1 «hasta el 31 de diciembre de 2030». Máxime si el art. 6.3 con su referencia al Anexo iii apartado 7 reconoce como objetivo y razonable que las autoridades encargadas del control fronterizo, de la migración y del asilo, sí pueden «proceder a evaluar riesgos de migración irregular, seguridad y salud». Estas autoridades encargadas de la aplicación de la ley «deben poder utilizar sistemas de información, de conformidad con el derecho de la Unión o el derecho nacional, para identificar a una persona que, durante un control de identidad, se niegue a ser identificada o no pueda declarar o demostrar su identidad» incluso sin una autorización previa (considerando 33).

Los reversos (i)limitados del Reglamento de IA: sesgos y riesgos asociados a la discriminación algorítmica en contextos migratorios

Los problemas de discriminación asociados al diseño del algoritmo y de la muestra de entrenamiento pueden tener su causa en cómo se definen la «variable objetivo» y las «etiquetas de clase», así como en cómo se realiza el etiquetado de los datos de entrenamiento, la recogida de los datos de entrenamiento, la selección de características y los proxies (FRA, 2022: 50); si bien la doctrina especializada (Leese, 2014; Xenidis, 2020) y los principales informes no descartan una alta probabilidad de que se produzca un trato discriminatorio como resultado de la aplicación de tales sistemas (EC 2020a, 2020b y 2021b). Esta irrefrenable capacidad de elaboración, evaluación y predicción de perfiles e indicadores de riesgo por aproximación adquieren una especial consideración cuando se pueden crear nuevos sesgos y reforzar estereotipos o prejuicios prexistentes hacia grupos históricamente marginados como las personas que cruzan fronteras regular o irregularmente y, en general, las personas migrantes. Por consiguiente, en este ámbito urge entender cuáles son las (im)posibilidades de revertir el trato discriminatorio y los procesos de estereotipización ya existentes, dados los nuevos retos que plantea la igualdad y la resiliencia del derecho antidiscriminatorio (Bartoletti y Xenidis, 2023; Morondo Taramundi, 2022).

a) Sesgos versus categorizaciones estereotipadas en los sistemas de IA aplicados en el contexto migratorio

La transformación inteligente de las fronteras exteriores de la UE y el despliegue tecnológico de sistemas basados en IA en el ciclo migratorio (Molnar, 2023: 309) contribuyen con mayor celeridad al etiquetado social y algorítmico14 de las personas migrantes bajo el pretexto de la seguridad, el miedo y la desconfianza. Basta observar que tanto si un algoritmo contiene sesgos relacionados con una característica protegida, como si se omite la información de características protegidas como género, edad y origen étnico, no se puede garantizar totalmente que un sistema de IA no discrimine ni que haya varios ejes de discriminación/vulnerabilidad interseccional (Vantin, 2021). Al contrario, nada impide que pueda hacerlo de forma indirecta o por aproximación (proxies), incluso si no hay datos sensibles para elaborar «indicadores de riesgo». Por ejemplo, el sexo puede indicar por aproximación la orientación sexual; la ciudad de residencia puede revelar la etnia y el color; el nivel de estudios y la ocupación indicarán la propiedad y la afiliación sindical; la nacionalidad podría ser un indicador indirecto de origen étnico o religión, etc. (Vavoula, 2021; Brouwer, 2023).

Precisamente por ello, la inocuidad de las posibles categorías de sesgos no es una cuestión menor cuando la recogida y el tratamiento de big data perpetúa discriminaciones incluso de forma meramente informativa hacia determinados individuos o grupos en favor de otros (Bartoletti y Xenidis, 2023: 15-19). Además, estas categorías generales, si son aplicadas al ciclo migratorio (Beduschi, 2022; Suresh y Guttag, 2021), pueden adquirir otras significaciones. Por ejemplo, de un lado, la perpetuación de sesgos históricos, dada la discordancia entre el mundo real y los valores u objetivos que se codifican y propagan en el sistema de IA; el sesgo de representatividad, al definir y muestrear la población migrante sin una representación adecuada ni una generalización correcta para el entrenamiento y la evaluación del sistema de IA. De otro lado, el sesgo de medición, al escoger y medir las características y etiquetas que se utilizarán como indicadores indirectos de las magnitudes deseadas, pueden omitir algunos factores importantes, o introducir un noise data relacionado con los grupos o los datos de entrada que conduzca a resultados diferentes. Y, de igual modo, no plantean problemas menores aquellos sesgos que se producen durante fases de construcción, iteración o evaluación del sistema de IA, como son el sesgo de agregación cuando se combinan incorrectamente poblaciones heterogéneas que deberían tratarse por separado (migración económica «regular o irregular» y «solicitante de protección internacional»), o bien el sesgo de evaluación cuando la referencia externa no representa en igual medida a los distintos sectores de la población migrante utilizados para el entrenamiento y la evaluación, o se abren al uso de parámetros de comportamiento no adecuados (bueno/malo o falso/verdadero, sospechoso/criminal). Todo ello, sin perjuicio de la inevitable producción de un sesgo de despliegue que se manifiesta cuando un sistema de IA se utiliza o interpreta de maneras inadecuadas gracias la interoperabilidad de los sistemas del Anexo X con fines policiales o preventivos.

En cualquier caso, Vantin (2021: 102) recuerda que el daño de los sesgos repercute sobre el grupo vulnerable, pero se extiende a los componentes de tal grupo, por lo que la desventaja, daño o prejuicio producido tendrá el efecto (por difracción) de consolidar o incrementar las discriminaciones estructurales o bien generar efectos desproporcionados sobre un grupo, más si cabe cuando se utilizan sets de datos de grandes dimensiones. De ahí que resulte extremadamente difícil, si no imposible, excluir la posibilidad de cualquier sesgo ni que se pueda garantizar en las mencionadas fases no causar efectos discriminatorios o nuevas formas de arbitrariedad, si las posibles limitaciones son delegadas a las autoridades responsables de diseñar o implementar un algoritmo y solo estas controlan el acceso a sus componentes técnicos esenciales.

Un primer reflejo concreto ya estudiado de la entidad práctica de estos efectos discriminatorios se produce, según Musco (2023: 45), cuando en el sistema de información ETIAS, la única limitación al desarrollador de algoritmos es permitir la elaboración de perfiles mediante la comparación de los indicadores de riesgo específico con los datos del expediente de solicitud (art. 33.4). Esta posibilidad deja margen para varias opciones de diseño no especificadas por el reglamento que, en la práctica, afectarán a la aplicación del algoritmo en el proceso de toma de decisiones, dada la prerrogativa soberana de los estados miembros de decidir quién entra en su territorio. Otro ejemplo de esta peligrosa tendencia tecnocéntrica, o tecnosolucionista, es la discrecionalidad técnica de la Agencia eu-LISA al considerar como «ruido» (noise data) las correlaciones y sesgos que arrojan tales sistemas de IA si tienen acceso o manejan información a gran escala, por ejemplo, en situaciones de entrada irregular o identificación de vulnerabilidades en frontera (Nedelcu y Soysüren, 2022) o incluso, añadiría, con anterioridad a la llegada por medio del uso de «inocuos» chatbots.

Ahora bien, en otro orden de cosas, estos sesgos y el impacto discriminatorio que plantean los proxie, pese al marco europeo de IA, trascienden y pueden exacerbar los procesos de estereotipización que ya permean el régimen jurídico y político de la inmigración y el asilo. Los estereotipos pueden responder a circunstancias o aspectos fácticos de las personas (y ser descriptivos), o a modelos de comportamiento (y ser en este sentido prescriptivos); en ambos casos, se establecen generalizaciones que no se detienen en recoger las peculiaridades individuales de los sujetos, sino que van más allá (Cook y Cusack, 2002). La categorización estereotipada de la movilidad humana (en posición regular, irregular, ya sea auténtica o falsa, etc.) puede llegar a ser criminalizada o etiquetada como una amenaza (Romano, 2023: 242) si tales herramientas de IA pueden inferir, orientar y determinar automáticamente la designación o serialización de estereotipos para diferenciar entre los múltiples estatutos migratorios, añadiendo el factor de credibilidad/veracidad para etiquetarlos como buenos/malos migrantes, verdaderos/falsos solicitantes de asilo, vulnerables (in)vulnerables, etc.

Así, la confianza en la fiabilidad algorítmica que se nutre del almacenamiento centralizado, entrenamiento y procesamiento automatizado de datos personales y biométricos pueden llegar a justificar estadísticamente la falsa conexión entre delincuencia e inmigración irregular para legitimar modelos punitivos, así como promover mayores medidas de lucha y prevención contra el terrorismo o el tráfico ilícito de personas. Esto es, el uso amplificado de la IA intensifica de facto la vigilancia de comportamientos sospechosos o poco creíbles de personas migrantes en los márgenes por medio de muestras sesgadas con implicaciones graves, no solo para las personas indocumentadas, sino también para aquellas documentadas que, ante la probabilidad de errores, además tienen difícil el acceso a la información sobre cómo se utilizan los datos y cómo pueden rectificarlos u obtener recursos efectivos en caso de abusos.

Al respecto, finalmente, cabe no olvidar, tal y como advierte Forti (2024: 3-4), que buena parte de los proyectos de aprendizaje automático o análisis predictivos basados en IA (véase tabla 1) pueden caer dentro de los denominados bucles de retroalimentación (feedback loop), que se producen cuando los resultados algorítmicos interpretan erróneamente la realidad e influyen en la aplicación de datos de entrenamiento para actualizar y desarrollar algoritmos. Los resultados engañosos y los estereotipos, además, pueden convertirse en entradas erróneas si se ajustan para otras rutinas de entrenamiento y solo buscan coincidencias exactas sin tener en cuenta las similitudes y correlaciones entre la información elaborada. Así pues, el resultado puede ser discriminatorio si la decisión adoptada basada en el sistema algorítmico conduce directa o indirectamente con efectos desproporcionados a un trato menos favorable incluso si está justificada objetiva y razonablemente para el fin que se emplea (Brouwer, 2020).

Por lo tanto, para determinar el alcance real de la discriminación algorítmica, un algoritmo debe evaluarse siempre dentro el contexto particular y la finalidad técnica de su uso (FRA, 2022: 24), admitiendo que, en contextos migratorios, su propósito persigue abiertamente predefinir las variables objetivo y las etiquetas de clase conforme a un marco normativo y político que no incluye tout court la condición migrante como patrón histórico de discriminación. De ahí que la única forma de garantizar estándares de protección vía Reglamento de IA no solo es prohibir aquella de origen étnico o racial sino «reducir la precisión general de todas las determinaciones y ampliar la diversidad de información» (Zuiderveen Borgesius, 2018: 55-60).

b) Riesgos asociados a los sistemas de IAen el contexto migratorio: dinámicas asimétricas de poder y de injusticia social

Si bien es cierto que desde la UE se ha realizado de forma bienintencionada un mapeo de los riesgos de la IA sobre los derechos de las personas migrantes (EDRI, 2022; FRA, 2020), con ello no se ha frenado la capacidad de crear nuevas vulnerabilidades intrínsecas a este espacio arquetípico de dinámicas asimétricas de poder y de injusticia social. Las personas migrantes vulnerables son un colectivo que soporta la carga de los sistemas estatales de vigilancia banóptica y panóptica (Leese et al., 2022: 6-7) ahora reconvertidos en «arquitecturas carcelarias» (Molnar, 2019). No solo para conducirlos hacia formas de movilidad (negocio o turismo) que se alientan o facilitan por su conformidad al sistema jurídico-político de entrada/salida, sino también para inhibir o desacelerar aquella espiral de amenazas asociadas a la «migración irregular», al «falso asilo» o a la criminalidad migrante (Leese, 2014). Por tanto, según Okzul (2023: 15), las implicaciones de la geopolítica de la movilidad humana asociadas a estas herramientas de IA tienen una doble vertiente dispar: de un lado, ayudar a las autoridades de inmigración e incluso a organizaciones humanitarias a planificar y asignar mejor sus recursos de antemano; y, de otro lado, aumentar la vigilancia de las fronteras y respaldar políticas de contención, expulsión y/o exclusión que restrinjan la migración en lugar de facilitarla, por medio de decisiones discrecionales (Molnar, 2019: 56) en defensa de la soberanía nacional amenazada o para mantener los privilegios entorno al conocimiento y las competencias de preconfiguración algorítmica de datos (Molnar, 2023: 48 y 49).

Así pues, sobre el alcance del riesgo en función de los diferentes actores implicados y sus objetivos, es necesario centrarse en el desequilibrio de posiciones de poder entre países con capacidad de IA o sin ella, esto es, los llamados «AI-capable» o «AI-dependent» (Beduschi, 2021: 4), y en la precariedad social y política (precarity) (Butler, 2009: 2) como «forma de agresión que no es inducida por el Estado, pero contra la que este no proporciona una protección adecuada». La puesta en marcha de proyectos experimentales como los mencionados de carácter preventivo, predictivo, procedimental o informativo, ya muestra evidencias sobre la exposición de las poblaciones sometidas arbitrariamente a la violencia estatal por su condición de personas migrantes racializadas, mediante una creciente vigilancia biotecnológica/biopolítica de control securitario sobre la movilidad humana no querida. Esta desigualdad y asimetría de poderes genera conflictos de intereses si el uso de la IA recae principalmente en el sector privado (IDEMIA; INDRA; SenseTime) que diseña y desarrolla tecnologías de IA que utilizarán los estados, las agencias y las organizaciones internacionales en todo el ciclo migratorio. Por tanto, estas interacciones entre los sectores público y privado suscitan inquietud no solo por la quiebra de la protección de datos y el principio de proporcionalidad (Jasmontaite-Zaniewicz y Zomignani, 2021), sino porque pueden tener mayor trasfondo en la producción unilateral de la «verdad o la credibilidad absoluta» sobre las personas migrantes. Por ejemplo, no podemos olvidar cómo, en los procesos automatizados de toma de decisiones relacionados con la migración y el asilo, a menudo, los derechos de autor y de propiedad intelectual de los creadores de sistemas de IA pueden obstaculizar la difusión de información sobre la creación de los algoritmos o el modelo de entrenamiento, lo que genera mayor inseguridad jurídica y falta de confianza sobre cómo y para qué pueden utilizarse o no los datos recopilados y sus correlaciones derivadas.

Por último, otro motivo añadido de creciente preocupación por este monopolio y desequilibrio de poder a nivel macro es advertido desde los debates sobre el «tecnocolonialismo» y el «colonialismo de datos» (Mejias y Couldry, 2019). No en vano, la apropiación con IA de datos y de muestras sesgadas abre la brecha del paradigma Norte y Sur Global, no solo bajo una fachada de objetividad y modernización amigable, sino porque puede facilitar nuevas formas de sobrexplotación, racismo y dominación15, especialmente hacia mujeres, minorías étnicas, personas con discapacidad y colectivos LGTBI. Estos colectivos integran a las personas más conocibles, experimentales, gobernables, rastreables e inteligibles (Molnar, 2019) y, según Romano (2023: 243), ello entraña una reificación o degradación del ser humano a un mero objeto. Esto es, comporta una pérdida de su autonomía y de su dignidad humana al ser tratados como datos «medio-fin» sin valor que se pueden filtrar, correlacionar, desechar o (re)usar sine die.

Algunas breve consideraciones

Si bien la UE se presenta como un escenario receptivo para proteger los derechos de las personas migrantes, al considerar su vulnerabilidad como una prioridad en la agenda europea, su trascendencia puede ser relativa, básicamente si se consideran los sesgos y riesgos asociados al creciente despliegue de sistemas tecnológicos basados en IA en contextos de control y gestión migratoria tras la plena vigencia y aplicación del Reglamento de IA. De hecho, no solo hay numerosas evidencias que dudan de su alcance prometedor, sino que en tales contextos, las mayores incertidumbres que plantean las prohibiciones y usos admisibles de IA en comparación con las que resuelve, niegan toda posible interpretación pro personae del Reglamento. No en vano, aunque la introducción progresiva de IA podría perseguir no solo fines punitivos sino también fines constructivos (operaciones humanitarias de salvamento, el análisis rápido y eficaz de las solicitudes de asilo y de la información, o logística en procesos de acogida-integración), la opacidad inherente al funcionamiento algorítmico, la imposibilidad de reducción del riesgo, el inevitable impacto discriminatorio de los sesgos y de los proxies (que no se mencionan) y la falta de garantías sólidas de los derechos en juego, no colman los vacíos de protección exigibles.

Además, tampoco los esfuerzos que se desprenden del Reglamento de IA parecen orientarse a evitar la previsible difracción algorítmica de sesgos y estereotipos de la aplicación de la IA, dado que ni tan siquiera se renuncia como «mal menor» a minimizar las repercusiones negativas que implica excluir los sistemas del Anexo x, especialmente para los grupos migrantes más vulnerables. Ello es difícilmente salvable si los regímenes de migración y de asilo tienen como base categorías migrantes estereotipadas y se asientan en el poder soberano de atribuir/cambiar espacios de libertad versus seguridad controlada, pero también si tales sistemas tienen el poder de responsabilizar sin atribuir responsabilidad o agencia a las personas migrantes simplemente para mantener inalterada la legitimidad o el statu quo del propio sistema. Así pues, por medio de justificaciones objetivas, excepciones o prórrogas (i)limitadas, la condición migrante sigue siendo relegada a los márgenes de los patrones históricos de discriminación de los sistemas jurídico-políticos y también ahora de los sistemas tecnológicos de IA, lo que crea escenarios migratorios y confines fronterizos cada vez más distópicos.

Referencias bibliográficas

Akhmetova, Roxana. «Efficient Discrimination: On How Governments Use Artificial Intelligence in the Immigration Sphere to Create and Fortify ‘Invisible Border Walls’». COMPAS, Working Paper 149, (2020), p. 1-23 (en línea) https://www.compas.ox.ac.uk/wp-content/uploads/WP-2020-149-Akhmetova_Eficient_Discrimination.pdf

Avello Martínez, María. «EU Borders and Potential Conflicts between New Technologies and Human Rights». Peace & Security – Paix et Sécurité Internationales, n.º 11, (2023), p. 1-33.

Bartoletti, Ivana y Xenidis; Raphaële. Study on the impact of artificial intelligence systems, their potential for promoting equality, including gender equality and the risks they may cause in relation to discrimination. Estrasburgo: Council of Europe, 2023.

Beduschi, Ana. «International migration management in the age of artificial intelligence». Migration Studies, vol. 9, n.º 3 (2021), p. 576-596.

Beduschi, Ana. Artificial intelligence, migration and mobility: implications for policy and practice. Ginebra: World Migration Report, 2022.Broeders, Dennis. «The New Digital Borders of Europe: EU Databases and the Surveillance of Irregular Migrants». International Sociology, vol. 22, n.º 1 (2007), p. 71-92.

Brouwer, Evelien. «Challenging Bias and Discrimination in Automated Border Decisions: Ligue des droits humains and the Right to Effective Judicial Protection». VerfBlog, (11 de mayo de 2023) (en línea) https://verfassungsblog.de/pnr-border/

Burgess, J. Peter y Kloza, Dariusz. Border control and new technologies. Addressing integrated Impact Assessment. Bruselas: Academic and Scientific Publishers, 2021.

Butler, Judith. «Performativity, precarity and sexual politics». AIBR. Revista de Antropología Iberoamericana, vol. 4, n.º 3 (2009), p. 1-13.

Chander, Anupam. «The racist algorithm?». Michigan Law Review, vol. 115, n.º 6 (2017), p. 1.023-1.045.

Cook, Rebecca J. y Cusack, Simone. Gender Stereotyping: Transnational Legal Perspectives. Filadelfia: University of Pennsylvania Press, 2010.

Cruz Ángeles, Jonatán. «Procesamiento informático de datos y protección de derechos fundamentales en las fronteras exteriores de la Unión Europea». Freedom, Security and Justice: European legal studies, n.º 1 (2020), p. 94-122.

Cruz Ángeles, Jonatán. «La nueva Ley de Inteligencia Artificial una aliada necesaria para gestionar controles fronterizos, migratorios y de asilo en la Unión Europea», en: Vestri, Gabriele (dir.) La disrupción tecnológica en la Administración Pública: retos y desafíos de la inteligencia artificial. Cizur Menor: Aranzadi, 2022, p. 97-121.

Garrido Carrillo, Francisco Javier. «La inteligencia artificial en el control de los flujos migratorios en la Unión Europea. La necesidad de un marco normativo garantista de los derechos fundamentales». Revista General de Derecho europeo, n.º 60 (2023), p. 1-39.

Derave, Charly; Genicot, Nathan y Hetmanska, Nina. «The Risks of Trustworthy Artificial Intelligence: The Case of the European Travel Information and Authorisation System». European Journal of Risk Regulation, vol. 13, n.º 3 (2022), p. 389-420.

Dumbrava, Costica. Artificial intelligence at EU borders. Overview of applications and key issues. Bruselas: European Parliamentary Research Service, 2021.

EC-European Commission. Communication from the Commission to the European Parliament and the Council on Smart borders: options and the way forward. Bruselas: EC, 2011.

EC-European Commission. Communication from the Commission to the European Parliament and the Council on Stronger and Smarter Information Systems for Borders and Security. Bruselas: EC, 2016.

EC-European Commission. The Use of Artificial Intelligence in Border Control, Migration and Security. Bruselas: EC, 2020a.

EC-European Commission. White paper on Artificial Intelligence - A European approach to excellence and trust. Bruselas: EC, 2020b.

EC-European Commission. Artificial Intelligence in EU Borders. Bruselas: EC, 2021a.

EC-European Commission. Feasibility study on an early warning and forecasting tool for migration based on artificial intelligence technology. Bruselas: EC, 2021b.

EC-European Commission. Opportunities and Challenges for the Use of Artificial Intelligence in Border Control, Migration and Security. Bruselas: EC, 2021c.

EDRi-European Digital Rights. Uses of AI in immigration and border control. A fundamental rights approval to the Artificial Intelligence Act. Bruselas: EDRi, 2022.

EMN-European Migration Network. The use of digitalization and artificial intelligence in migration management.Bruselas: EMN, 2022.

FRA-European Union Agency for Fundamental Rights. Facial recognition technology: fundamental rights considerations in the context of law enforcement. Viena: FRA publications, 2020.

FRA-European Union Agency for Fundamental Rights. Bias in Algorithms – Artificial Intelligence and Discrimination. Viena: FRA publications, 2022.

Forti, Mirko. «Addressing Algorithmic Errors in Data-Driven Border Control Procedures». German Law Journal, vol. 25, n.º 1 (2024), p. 1-11.

Guild Elspeth y Vavoula, Niovi. «Travel Authorization in the EU: Automated Processing and Profiling». OpenDemocracy, (12 de octubre de 2020) (en línea) https://www.opendemocracy.net/en/can-europe-makeit/travel-authorization-eu-automated-processing-and-profiling/

Jasmontaite-Zaniewicz, Lina y Zomignani Barboza, Júlia. «Disproportionate surveillance: technology assisted and automated decisions in asylum applications in the EU?». International Journal of Refugee Law, n.º 33 (2021), p. 89-110.

Kilpatrick, Jane y Jones, Chris. A clear and present danger. Missing safeguards on immigration and asylum EU’s AI act. Londres: Statewatch, 2022.

Leese, Mathias. «The new profiling: Algorithms, black boxes, and the failure of anti-discriminatory safeguards in the European Union». Security Dialogue, vol. 45, n.º 5 (2014), p. 494-511.

Leese, Mathias; Noori, Simon y Scheel, Stephan. «Data Matters: The Politics and Practices of Digital Border and Migration Management». Geopolitics, 27, n.º 1 (2022), p. 5-25.

Loddo, Olimpia Giuliana y Addis, Andrea. «Tre funzioni dell’IA nella gestione dei flussi migratori». Adimblog, Analisi & Opinioni, (enero de 2023) (en línea) https://www.adimblog.com/2023/01/31/tre-funzioni-dellia-nella-gestione-dei-flussi-migratori/

Marin, Luisa. «Is Europe Turning into a ‘Technological Fortress’? Innovation and Technology for the Management of EU’s External Borders», en: Heldeweg, Michiel A. y Kica, Evisa (eds.) Regulating Technological Innovation: Legal and Economic Regulation of Technological Innovation. Londres: Palgrave Macmillan, 2011, p. 131-151.

Mejías, Ulises y Couldry, Nick. «Colonialismo de datos: repensando la relación de los datos masivos con el sujeto contemporáneo». Virtualis, vol. 10, n.º 18 (2019), p. 78-97.

Molnar, Petra. «Technology on the Margins: AI and Global Migration Management from a Human Rights Perspective». Cambridge International Law Journal, 8, n.º 2 (2019), p. 305-330.

Molnar, Petra. «Digital border technologies, techno-racism and logics of exclusion». International Migration, vol. 61, n.º 5 (2023), p. 307-312.

Molnar, Petra. AI surveillance and border tech experiments. Nueva York: The New Press, 2024.

Moreno Rebato, Mar. Inteligencia artificial (umbrales éticos, derecho y administraciones públicas). Cizur Menor: Aranzadi, 2021.

Morondo Taramundi, Dolores. «Discrimination by Machine-Based Decisions: Inputs and Limits of Anti-discrimination Law», en: Custers, Bart, Fosch-Villaronga; Eduard (eds.) Law and Artificial Intelligence. La Haya: T.M.C. Asser Press/Springer, 2022, p. 73-85.

Musco Eklund, Amanda. «Rule of Law Challenges of ‘Algorithmic Discretion’ & Automation in EU Border Control. A Case Study of ETIAS Through the Lens of Legality». European Journal of migration and Law, vol. 25, n.º 3 (2023), p. 249-274.

Nalbandian, Lucia. «An eye for an ‘I:’ a critical assessment of artificial intelligence tools in migration and asylum management». Comparative Migration Studies, vol. 10, n.º 32 (2022), p. 1-23.

Napolitano, Antonella. Artificial intelligence: the new frontier of the EU’s border externalisation strategy. Copenhague: EuroMed rights, 2023.

Nedelcu, Mihaela y Soysüren, Ibrahim. «Precarious migrants, migration regimes and digital technologies: the empowerment-control nexus». Journal of Ethnic and Migration Studies, vol. 48, n.º 8 (2022), p. 1.821-1.837.

Oliveira Martins, Bruno y Gabrielsen Jumbert, Maria. «EU Border technologies and the co-production of security ‘problems’ and ‘solutions’». Journal of Ethnic and Migration Studies, vol. 48, n.º 6 (2022), p. 1.430-1.447.

Ozkul, Derya. Automating Immigration and Asylum: The Uses of New Technologies in Migration and Asylum Governance in Europe. Oxford: Refugee Studies Centre, University of Oxford, 2023.

Romano, Andrea. «Derechos fundamentales e inteligencia artificial emocional en iBorderCtrl: retos de la automatización en el ámbito migratorio». Revista Catalana de Dret Públic, n.º 66 (2023), p. 237-252.

Ruiz Tarrías, Susana. «La búsqueda del modelo regulatorio de la IA en la Unión Europea». Anales de la Cátedra Francisco Suárez, n.º 57 (2023), p. 91-119.

Suresh, Harini y Guttag, John. «A Framework for Understanding Sources of Harm throughout the Machine Learning Life Cycle», en: Proceedings of EAAMO ’21: Equity and Access in Algorithms, Mechanisms, and Optimization (EAAMO ’21), (octubre de 2021) (en línea) https://dl.acm.org/doi/fullHtml/10.1145/3465416.3483305

UN Special Rapporteur on Contemporary forms of racism, racial discrimination, xenophobia and related intolerance. «Racial and xenophobic discrimination, emerging digital technologies, and border and immigration enforcement». UN, A/HRC/44/57, (18 de junio de 2020) (en línea) https://digitallibrary.un.org/record/3879751?v=pdf

Vantin, Serena. Il diritto antidiscriminatorio nell’era digitale. Potenzialità e rischi per le persone, La Pubblica Amministrazione, le imprese. Milán: Wolters Kluwer, 2021.

Vavoula, Niovi. «Artificial Intelligence (AI) at Schengen Borders: Automated Processing, Algorithmic Profiling and Facial Recognition in the Era of Techno-Solutionism». European Journal of Migration and Law, n.º 23 (2021), p. 457-484.

Veale, Michael y Zuiderveen Borgesius, Frederik. «Demystifying the Draft EU Artificial Intelligence Act». CRi, n.º 4 (2021), p.1-16.

Xenidis, Raphaël. «Tuning EU equality law to algorithmic discrimination: Three pathways to resilience». Maastricht Journal of European and Comparative Law, vol. 27, n.º 6 (2020), p. 736-758.

Zuiderveen Borgesius, Frederik. Discrimination, artificial intelligence, and algorithmic decision-making. Estrasburgo: Council of Europe, Directorate General of Democracy, 2018.

Notas:

1- Según EMN (2022: 10-11), se aplican los siguientes sistemas de reconocimiento del habla: DIAS en Alemania; TILDE en Letonia; sistemas de identificación de identidad TIKKA en Finlandia; y reconocimiento facial en Grecia, Hungría y Letonia.

2- Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 202, por el que se establecen normas armonizadas en materia de inteligencia artificial. Véase: https://eur-lex.europa.eu/legal-content/ES/TXT/?uri=OJ%3AL_202401689

3- Reglamento (UE) 2022/1190 del Parlamento Europeo y del Consejo de 6 de julio de 2022 (…) DO L 185, del 12 de julio de 2022.

4- Reglamento UE 2024/1358 del Parlamento Europeo y del Consejo, de 14 de mayo de 2024 (…) DO L, 2024/1350, del 22 de mayo de 2024.

5- Reglamento (UE) 2021/1133 del Parlamento Europeo y del Consejo de 7 de julio de 2021 (…) DO L 248, del 13 de julio de 2021.

6- Reglamento (UE) 2017/2226 del Parlamento Europeo y del Consejo, de 30 de noviembre de 2017 (…) DO L 327, del 9 de diciembre de 2017 modificado por el Reglamento (UE) 2024/1356 del Parlamento y del Consejo de 14 de mayo de 2024 (…) DO L, 2024/1350, del 22 de mayo de 2024.

7- Reglamento (UE) 2018/1240 del Parlamento Europeo y del Consejo, de 12 de septiembre de 2018 (…) DO L 249, del 14 de julio de 2021, modificado por el Reglamento (UE) 2024/1356 del Parlamento y del Consejo de 14 de mayo de 2024 (…) DO L, 2024/1350, del 22 de mayo de 2024.

8- Reglamento (UE) 2019/816 del Parlamento Europeo y del Consejo, de 17 de abril de 2019 (...) DO L 135, del 22 de mayo de 2019 modificado por el Reglamento (UE) 2024/1352 del Parlamento y del Consejo de 14 de mayo de 2024 (…) DO L, 2024/1350, del 22 de mayo de 2024.

9- El primero ha sido modificado por el Reglamento (UE) 2021/1150 del Parlamento Europeo y del Consejo del 7 de julio de 2021 (…) DO L 249, del 14 de julio de 2021. Mientras que, el segundo, por el Reglamento (UE) 2021/1151 del Parlamento Europeo y del Consejo de 7 de julio de 2021, DO L 249, del 14 de julio de 2021, el Reglamento (UE) 2021/1152 del Parlamento Europeo y del Consejo de 7 de julio de 2021 (…) DO L 249, del 14 de julio de 2021 y el Reglamento (UE) 2024/1352 del Parlamento y del Consejo de 14 de mayo de 2024 (…) DO L, 2024/1350, del 22 de mayo de 2024.

10- Chatbots de asistente virtual como NATALI y LEPINE en Francia; DEMS en los Países Bajos; MIGAPP de la OIM; REFUGEE BUDDY de la Cruz Roja en los Países Bajos, Noruega y Canadá; LOVE EUROPE; TIMEPEACE APP en el Reino Unido; ANKOMMEN en Alemania; FINDAWAY en el sur de Francia; MOBILEARN en Suecia; KAMU en Finlandia; (RE)settle in Croatia, en Croacia (EMN, 2022).

11- Entre otros, MATCH’IN en Alemania; GEOMATCH en Suiza y los Países Bajos, y MOT en Noruega (Okzul, 2023).

12- Reglamento (UE) 2024/1356 del Parlamento Europeo y del Consejo, del 14 de mayo de 2024, por el que se introduce el triaje de nacionales de terceros países en las fronteras exteriores y se modifican los Reglamentos (CE) nº 767/2008, (UE) 2017/2226, (UE) 2018/1240 y (UE) 2019/817.

13- Entre otros, véase el proyecto Tresspass, Centaur, Hyperion, Solomon.

14- Recomendación CM/Rec(2020)1 del Comité de Ministros a los estados miembros sobre las repercusiones de los sistemas algorítmicos en los derechos humanos (adoptada por el Comité de Ministros el 8 de abril de 2020 en la 1373ª reunión de los Delegados de los Ministros).

15- Comité Asesor del Consejo de Derechos Humanos de Naciones Unidas. «Promover la justicia y la igualdad raciales desarraigando el racismo sistémico» (8 de agosto de 2023), UN Doc. A/HRC/54/70, párr. 7.

Este trabajo se ha realizado con el apoyo del Proyecto Derechos Humanos y retos socioculturales en un mundo en transformación (ref.: IT1468-22) y del Proyecto I+D+i RESEST «Resiliencia del derecho antidiscriminatorio a los sesgos y estereotipos: desafíos y propuestas de intervención» (ref. PID2021-123171OB-I00), del Ministerio de Ciencia e Innovación.

Palabras clave: migraciones, IA, derechos humanos, discriminación algorítmica, sesgos, estereotipos, Unión Europea (UE)

Cómo citar este artículo: La Spina, Encarnación. «La regulación europea de la IA ante los sesgos y riesgos de discriminación algorítmica en contextos migratorios». Revista CIDOB d’Afers Interna-cionals, n.º 138 (diciembre de 2024), p.171-194 . DOI: doi.org/10.24241/rcai.2024.138.3.171

Revista CIDOB d’Afers Internacionals, nº 138, p.171-194

Cuatrimestral (septiembre-diciembre 2024)

ISSN:1133-6595 | E-ISSN:2013-035X

DOI: https://doi.org/10.24241/rcai.2024.138.3.171

Fecha de recepción: 17.03.2024 ; Fecha de aceptación: 09.09.2024