Inteligencia artificial y ciudades: la carrera global hacia la regulación de los algoritmos

Existe una necesidad creciente de asegurar que el desarrollo y uso de aplicaciones de inteligencia artificial (IA) no comprometa los derechos fundamentales. Esto ha precipitado una carrera global entre grandes potencias, foros y organizaciones internacionales, así como empresas y organismos públicos y privados, por fijar los estándares que deben gobernar y regular este fenómeno.

Ante un contexto regulatorio global fragmentado, las ciudades se están posicionando como actores normativos muy relevantes.

Las ciudades asumen un papel regulador individualmente, mediante el desarrollo de estándares e iniciativas de gobernanza locales, pero también colectivamente, en el marco de alianzas de ciudades como la CC4DR o Eurocities.

La inteligencia artificial (IA) dejó de evocar un futuro de ciencia ficción mucho antes de que los debates sobre el potencial del sistema ChatGPT irrumpieran en nuestras vidas a finales de 2022. De hecho, como lo fuera la electricidad o la irrupción de Internet en su momento, la IA promete ser una de las fuerzas más transformadoras de nuestro tiempo, con potencial para revolucionar todas las industrias y sectores económicos. Sus aplicaciones son infinitas: toma de decisiones algorítmicas, tratamiento masivo de grandes volúmenes de datos, sistemas de procesamiento de lenguaje natural y de voz, predicción de situaciones de riesgo, o incluso el controvertido reconocimiento biométrico. Aplicaciones que, la mayoría de ellas, ya se usan de manera recurrente en sectores tan diversos como los de la justicia, la gestión de recursos humanos, los servicios financieros, la movilidad, la sanidad o la provisión de servicios públicos.

No es casual que las inversiones en IA se hayan disparado en todo el mundo, ni que, cada vez más, encontremos este concepto en las estrategias de seguridad nacional de muchos gobiernos. Tampoco debería sorprender que se hayan precipitado las dinámicas competitivas para dominar el desarrollo de la IA en una suerte de «carrera global hacia la IA», de la que participan explícitamente tanto las grandes potencias como las grandes plataformas tecnológicas. «Quien domine la inteligencia artificial, dominará el mundo», advertía Vladimir Putin en 2017 y, desde entonces, esta carrera global no ha hecho más que acelerarse.

Los sistemas de IA son mucho más que meros componentes de software. De hecho, tan o más importante que estos es el sistema sociotécnico que los rodea. Así, cualquier debate sobre la IA y su gobernanza debería considerar necesariamente las organizaciones que la crean, desarrollan, implementan, usan y controlan, además de los individuos que se van a ver afectados por ella o las nuevas relaciones sociales que generan. Esto es así porque el uso de sistemas de IA tiene implicaciones éticas y legales muy significativas, pudiendo llegar a comprometer una gran variedad de derechos fundamentales como pueden ser el de la privacidad, la no discriminación o la protección de datos. Es más, la IA puede tener (y ya está teniendo) un impacto adverso sobre la democracia y el Estado de derecho, en particular, en lo que se refiere a su potencial para influir en los discursos sociales y políticos, manipular la opinión pública a través de la producción y difusión de contenido en redes sociales, filtrar el acceso a la información, o generar nuevas desigualdades.

En este contexto, cada vez más se insta a los gobiernos no solo a impulsar políticas para estimular la innovación en IA, sino también a adoptar medidas para proteger a nuestras sociedades de los riesgos que puede comportar el uso de esta tecnología disruptiva. De esta forma, a la «carrera por desarrollar la IA» se le ha sumado la «carrera por regular la IA», donde ser el primero en actuar puede dar una ventaja competitiva nada despreciable. En este nuevo campo de juego que se ha abierto, además, los gobiernos nacionales no están solos, ya que, ante su lento actuar, las ciudades –una vez más– se están posicionando como actores indispensables para el desarrollo de una IA ética y responsable.

Un contexto global fragmentado

La gobernanza global de la IA se articula hoy a través de una multitud de marcos normativos e iniciativas fraccionados, heterogéneos y dispersos impulsados por varios actores. A estas alturas, todas las grandes potencias ya han publicado sus estrategias para promover el uso y el desarrollo de la IA y, desde 2016, se han empezado a coordinar esfuerzos (de manera no demasiado exitosa) en el marco de foros intergubernamentales como el G-7 o el G-20. Algunas organizaciones internacionales como la Unesco o la Organización para la Cooperación y el Desarrollo Económico (OCDE) también se han apuntado a esta competición por formular estándares regulatorios globales para la IA, como también lo han hecho muchas empresas, centros de investigación, organizaciones de la sociedad civil y gobiernos subnacionales.

Sin duda nos encontramos ante un contexto global fragmentado, que se explica por diferentes factores como la ambigüedad del mismo concepto de «inteligencia artificial»1. En este sentido, destacan las diferencias fundamentales que existen entre los modelos de gobernanza tecnológica promovidos por los tres bloques regionales más importantes del mundo (Estados Unidos, China y la Unión Europea [UE]) o la ausencia de un marco regulatorio realmente global impulsado por organizaciones internacionales. A ello cabe añadir las dificultades por conjugar intereses, normas y códigos de conducta comunes entre corporaciones privadas (que son los principales desarrolladores de esta tecnología), los gobiernos y la opinión pública.

Como en otras esferas de la gobernanza tecnológica global, Estados Unidos, China y la UE mantienen diferencias ideológicas muy significativas con respecto a la regulación de datos y la gobernanza de la IA. Es una confrontación de modelos que tiene considerables ramificaciones geopolíticas, lo que está condicionando sobremanera las iniciativas del resto de actores del sistema internacional. Por ello, merece la pena entretenerse a entender las diferencias principales entre estos tres enfoques, que podríamos caracterizar, a grandes rasgos, como la autorregulación capitalista de Estados Unidos, el tecno-autoritarismo de China y la regulación integral garantista de la Unión Europea.

La regulación de la UE

La UE es, en muchos sentidos, pionera en la regulación del ámbito digital desde una perspectiva garantista y de defensa del consumidor. Su Reglamento General de Protección de Datos (GDPR, por sus siglas en inglés), que entró en vigor en 2018, sentó un precedente para la regulación de datos a nivel global2, puesto que inspiró otra legislación similar en Estados Unidos y China. Del mismo modo, la Ley de Inteligencia Artificial (AI Act), presentada por la Comisión Europea en 2021 y aún en negociación, constituye uno de los esfuerzos regulatorios más avanzados en este ámbito que puede marcar un nuevo estándar global.

Con todo, esta propuesta legislativa debe contextualizarse en el marco de otras iniciativas que conforman la política europea en materia de inteligencia artificial, iniciada en 2018, y que incluyen, entre otras, la Estrategia Europea de Inteligencia Artificial (2018), las Directrices éticas para una IA fiable (2019) –formuladas por el Grupo de Expertos de Alto Nivel sobre IA– y el Libro Blanco de la UE sobre IA (2020). En cualquier caso, la Ley de Inteligencia Artificial, que podría entrar en vigor en 2024 y que supone una nueva e innovadora regulación basada en el riesgo que conlleva la IA, junto con la Ley de Mercados Digitales (DMA) y la Ley de Servicios Digitales (DSA) conforman un enfoque holístico de cómo las autoridades buscan gobernar el uso de la IA y la tecnología de la información en la sociedad.

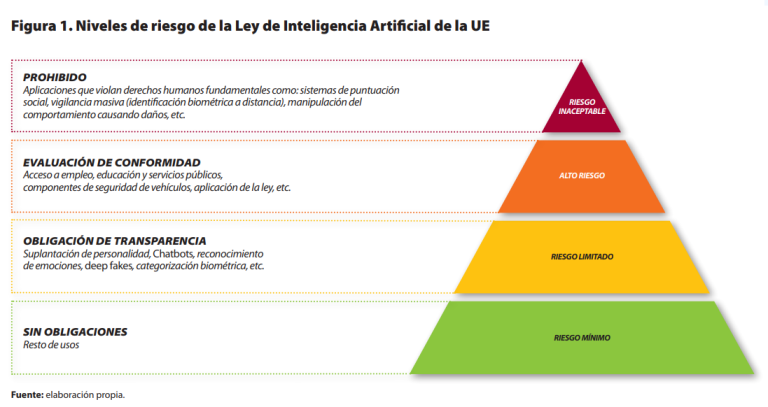

Específicamente, la Ley de la IA persigue dos objetivos fundamentales: a) regular los usos de la IA con el fin de abordar los beneficios y riesgos de esta tecnología, y b) crear un espacio seguro para la innovación en IA que cumpla con un alto nivel de protección del interés público, la seguridad y los derechos y libertades fundamentales. Asimismo, persigue la conformación de un ecosistema de confianza que fomente la adopción de servicios de IA. Para ello, sigue un enfoque regulatorio basado en el riesgo; es decir, la ley aplica determinadas obligaciones y restricciones en función de cuatro niveles de riesgo derivados del uso de la IA (véase la figura 1).

La regulación de China

Por su parte, en 2017, China adoptó el «Plan de Desarrollo de la IA de la próxima generación», que detallaba los principios y los objetivos estratégicos que deben guiar el desarrollo de la IA en un amplio abanico de sectores. El objetivo sin duda era convertir el país en un líder mundial en este campo. Desde entonces, China ha desarrollado otros mecanismos para regular el desarrollo de la IA, especialmente en el campo de la supervisión algorítmica y de datos. Destaca, en este sentido, la Ley de Protección de Información Personal (PILP), aprobada en 2021 e inspirada en gran parte en el GDPR europeo. Asimismo, en marzo de 2022 entró en vigor una nueva regulación orientada a supervisar las «recomendaciones algorítmicas de los motores de navegación de Internet». En concreto, esta regulación otorga a los usuarios nuevos derechos, incluida la posibilidad de optar por no utilizar algoritmos de recomendación y eliminar los datos del usuario. Sin embargo, también incluye unas disposiciones algo más opacas sobre moderación de contenido que requieren que las empresas privadas promuevan activamente información «positiva» que siga la línea oficial del Partido Comunista. En este sentido, la regulación de los algoritmos de China va mucho más allá del espacio digital, pues también dicta qué tipo de comportamiento el Gobierno chino considera favorable o no en la sociedad. A este enfoque, caracterizado por muchos como tecno-autoritario, se contrapone el de Estados Unidos.

La regulación de Estados Unidos

La aproximación estadounidense responde a lógica del «capitalismo de vigilancia». Si empezamos por la regulación de la protección de datos, cabe destacar que Estados Unidos aún no cuenta con una ley nacional en este ámbito, algo que pueda ser equiparable al GDPR europeo. Ante esta inacción del Gobierno federal, cinco estados (California, Colorado, Connecticut, Utah y Virginia) han adoptado algún tipo de legislación3. En el ámbito de inteligencia artificial, tampoco existe una regulación a escala estatal, si bien la Algorithmic Accountability Act (2022) es un primer paso en esta dirección.

De hecho, el desarrollo tardío de una regulación a nivel estatal puede atribuirse a la oposición significativa, por parte de la sociedad, al uso de la IA en el sector público, muy especialmente al uso de tecnologías de reconocimiento facial por parte de las fuerzas del orden público. En este sentido, si bien Estados Unidos y la UE divergen en la regulación de la IA (autorregulación versus regulación integral), ambas potencias comparten la voluntad de vincular las iniciativas de regulación a la protección de derechos digitales básicos. En ausencia de legislación nacional que las reconozca explícitamente, algunas entidades subnacionales han comenzado a implementar sus propias regulaciones, como se explicará a continuación.

El poder normativo colectivo de las ciudades4

La IA promete beneficios a todos los niveles, pero es en las ciudades donde más se está experimentando, al combinarse su adopción, en la mayoría de los casos, con otras tecnologías como el Internet de las cosas, el 5G o el Big Data. También son los entornos urbanos el lugar donde su impacto resulta más tangible. Hoy, muchos gobiernos locales ya usan regularmente la IA para predecir la demanda de algunos servicios, anticipar problemáticas, comunicarse más rápidamente con los ciudadanos mediante chatbots, mejorar la toma de decisiones o avanzar hacia sus objetivos de sostenibilidad, sobre todo en áreas como la calidad del aire o la movilidad.

Sin embargo, esta creciente adopción de la IA en entornos urbanos no está exenta de desafíos, especialmente en lo que se refiere a las habilidades que requieren las ciudades para aprovechar todo su potencial. Existe, además, el imperativo de asegurar que el uso de soluciones basadas en IA cumpla con los estándares de seguridad y responsabilidad, protegiendo los derechos digitales de la ciudadanía. Dar respuesta a estos retos requiere de actuaciones que van mucho más allá de la capacidad de legislar de los gobiernos locales. No obstante, ante un contexto regulatorio global fragmentado y la existencia de vacíos legales notables, las ciudades se están posicionando como actores normativos indispensables, ya sea individualmente mediante el desarrollo de estándares locales, ya sea colectivamente en el marco de alianzas y redes de ciudades.

En el ámbito de la actuación colectiva de las ciudades, es referencia obligada el trabajo que está desarrollando la Coalición de Ciudades por los Derechos Digitales (Cities Coalition for Digital Rights [CC4DR]). Esta es una iniciativa lanzada en noviembre de 2018 por las ciudades de Barcelona, Ámsterdam y Nueva York, que cuenta con el apoyo de ONU-Hábitat y cuya misión es la promoción y defensa de los derechos digitales en entornos urbanos. Concebida como una alianza pragmática basada en principios, sus ciudades miembros (actualmente alrededor de 50) comparten buenas prácticas y conocimiento experto para abordar desafíos comunes vinculados a la formulación de políticas basadas en derechos digitales. Es una coalición, además, que trabaja para elaborar marcos legales, éticos y operativos que ayuden a las ciudades a promover los derechos humanos en entornos digitales.

En julio de 2021, la CC4DR puso en marcha el Observatorio Global de Inteligencia Artificial Urbana (GOUAI, por sus siglas en inglés), con el fin de promover sistemas éticos de IA en las ciudades5. El GOUAI persigue tres objetivos fundamentales. En primer lugar, contribuir a la definición de unos principios éticos básicos que puedan guiar la adopción de soluciones de IA en las ciudades; concretamente, se busca que las herramientas algorítmicas empleadas en entornos urbanos sean justas y no discriminatorias, transparentes y abiertas, responsables, ciberseguras, que salvaguarden la privacidad de los ciudadanos y que sean sostenibles. En segundo lugar, apoyar la operacionalización de estos principios, mediante el mapeo de proyectosy estrategias de IA urbana ética de referencia. Estas buenas prácticas, desarrollas por ciudades de todo el mundo, pueden consultarse en el «Atlas of Urban AI» lanzado en 2022. Finalmente, el GOUAI se propone diseminar estos principios y buenas prácticas entre la comunidad urbana internacional, a fin de promover la regulación de la IA con perspectiva ética desde lo local.

Asimismo, a través de las asociaciones municipalistas, los gobiernos locales también están intentando incidir políticamente en la negociación de regulaciones transnacionales como, por ejemplo, la Ley de IA de la UE (AI Act). Aquí destaca el rol de Eurocities, la red de las grandes ciudades europeas conformada por más de 200 miembros de 38 países. A principios de 2020, Eurocities formuló una respuesta al Libro Blanco de la Comisión Europea sobre inteligencia artificial, en la que se detallaban las oportunidades y retos de las IA para las ciudades europeas y se abogaba, entre otras peticiones, por la inclusión de representantes de gobiernos locales en el grupo de trabajo sobre IA de la UE, más financiación para el desarrollo de habilidades y alfabetización digital en los gobiernos municipales, o que el futuro marco regulatorio de la UE para una IA confiable tenga en cuenta los principios éticos definidos en el sí de la CC4DR.

Tras la publicación de la propuesta de la Comisión Europea para la futura Ley de IA en 2021, Eurocities dedicó esfuerzos importantes a fomentar la discusión entre sus miembros alrededor de la relevancia y las implicaciones de esta regulación europea para los gobiernos locales. Ello se tradujo en la presentación de enmiendas concretas en nombre de las ciudades a la propuesta de reglamento, así como en la organización de actividades para seguir incidiendo en las negociaciones. Un ejemplo concreto sería la carta enviada a los relatores del reglamento.

En cuanto al posicionamiento político común en este ámbito, en general las ciudades están a favor de la definición amplia de sistemas de IA que se incluye en la Ley de IA, como también apoyan el enfoque basado en el riesgo y la propuesta de prohibir los usos inaceptables. Piden, sin embargo, la prohibición total de los sistemas de captura masiva de datos biométricos en espacios públicos hasta que pueda verificarse el respeto a los derechos humanos. Asimismo, denuncian la falta de alineación de los sistemas de IA con el Reglamento General de Protección de Datos de la UE.

Regular desde abajo: instrumentos locales para gobernar la IA6

Ante los límites y déficits de la mayoría de las legislaciones nacionales, muchas ciudades han comenzado a desarrollar sus propios marcos de gobernanza e instrumentos normativos para asegurar un uso responsable de la IA en sus jurisdicciones. Así, de manera análoga a los esfuerzos desempeñados por algunos países y organizaciones internacionales, los gobiernos locales están definiendo marcos normativos éticos y los principios rectores que deben guiar la aplicación municipal de una IA responsable y basada en los derechos humanos. Estos principios éticos suelen quedar recogidos en declaraciones y estrategias municipales.

Un buen ejemplo de ello es la «Estrategia municipal de algoritmos y datos para el impulso ético de la inteligencia artificial» de Barcelona, publicada en 2021. En ella se define un modelo de gobernanza de la IA basada en los derechos digitales y los principios democráticos. Entre las medidas que se incluyen, destaca la creación de un registro público de algoritmos, o el establecimiento de cláusulas a la compra pública para asegurar que las licitaciones municipales de sistemas de IA sean respetuosas con los derechos humanos. Otra ciudad pionera en este sentido es Nueva York, cuya «Estrategia sobre IA» (de octubre 2021)7 también apela a que la ciudad se beneficie del uso de la IA de manera ética y responsable, teniendo en cuenta los derechos digitales. Específicamente, la estrategia detalla cómo modernizar la infraestructura de datos de la ciudad y define las áreas en las que la IA tiene el potencial de introducir más beneficios con el menor daño posible, así como las formas en que la administración puede usar la IA internamente para servir a los ciudadanos. Finalmente, esta estrategia contempla la realización de alianzas con centros de investigación, así como actuaciones específicas para garantizar que un mayor uso de la IA no vaya en detrimento de los derechos digitales de los neoyorquinos.

En el contexto latinoamericano, destaca la ciudad de Buenos Aires, que tiene un «Plan de IA» (agosto 2021) orientado a maximizar el aprovechamiento de los beneficios de la IA para la gestión de la ciudad, acompañar la evolución y consolidación del uso de la IA en industrias y áreas estratégicas clave del entramado productivo y del gobierno, así como mitigar los potenciales riesgos derivados del uso de la IA, definiendo unos principios éticos y legales, como la transparencia, la privacidad, la ciberseguridad, el respeto al medio ambiente, la responsabilidad, la intervención humana y el gobierno abierto.

Más allá de estas estrategias holísticas, algunas ciudades están impulsando reglamentos específicos para establecer límites en el uso de la IA en sus comunidades, especialmente en esos casos donde existe el riesgo de que el uso de sistemas automatizados pueda conducir a discriminaciones y quebramiento de derechos fundamentales. Es el caso de la Ley de Nueva York sobre los sistemas de contratación automatizados, que estipula que cualquier de estos sistemas usado en la ciudad a partir de abril de 2023 debe someterse a una auditoría de sesgo para evaluar su posible impacto dispar en algunos grupos. Otro ejemplo són los reglamentos impulsados por muchas otras ciudades estadounidenses, como Boston, Minneapolis, San Francisco, Oakland o Portland, para prohibir a agencias gubernamentales –incluida la policía– el uso de tecnologías de reconocimiento facial. Estas prohibiciones son el resultado de la preocupación por la violación de las libertades civiles y la discriminación incrustadas en estas herramientas a través de sesgos en los datos y en los algoritmos.

Por último, determinadas políticas públicas locales pueden tener un impacto normativo tan profundo como algunos de los reglamentos anteriormente mencionados. Es el caso de la creación de registros de algoritmos en Ámsterdam y en Helsinki, una iniciativa pionera mediante la cual estas dos ciudades publican en portales web públicos información sobre los sistemas algorítmicos usados para prestar algunos servicios, constituyéndose en una herramienta fundamental para garantizar la transparencia y rendición de cuentas. Tal es su importancia que otras siete ciudades europeas (Barcelona, Boloña, Bruselas, Eindhoven, Mannheim, Rotterdam y Sofia), con el apoyo de Eurocities, han unido esfuerzos con Ámsterdam y Helsinki para desarrollar un esquema de datos estandarizado que establezca la información que se debería publicar en los registros de algoritmos. Con ello, estas ciudades se están posicionando como pioneras en esta carrera por regular la IA desde lo local.

Apunte final

Existe una necesidad cada vez más acuciante de asegurar que el desarrollo y uso de aplicaciones de IA no comprometa los derechos fundamentales. Esta constatación ha precipitado una nueva carrera global por fijar los estándares que deben gobernar y regular la IA. Con la proliferación de iniciativas normativas de diferente naturaleza, se ha abierto un terreno de juego en el que participan no solo las grandes potencias, sino también otros actores como organismos intergubernamentales, las grandes plataformas tecnológicas, organizaciones de la sociedad civil, y las ciudades.

En un contexto global de fragmentación normativa y antagonismo de modelos de gobernanza de lo digital, escalar las regulaciones que están adoptando muchas ciudades del mundo puede convertirse en una manera práctica, ágil y eficaz para acelerar la adopción de soluciones de IA a todos los niveles. Al fin y al cabo, de la misma manera que las ciudades son hoy centros incuestionables de innovación y espacios de experimentación para la respuesta a grandes desafíos globales como el cambio climático, las fronteras de la gobernanza de la IA también se pueden empezar a definir en gran medida desde abajo.

Cabe recalcar, sin embargo, que hoy en día el trabajo normativo de las ciudades en materia de regulación de la IA es, esencialmente, un fenómeno del Norte Global. Es significativo, por ejemplo, que el 90% de las ciudades de la Coalición de Ciudades por los Derechos Digitales sean europeas o de Estados Unidos. En este sentido, quizás sea relevante preguntarse si el espíritu garantista y de protección de los derechos digitales a la que responden la mayoría de estas regulaciones también puede acabar inspirando iniciativas similares en otros contextos donde la lógica imperante es la tecno-autoritaria.

Referencia

Finnemore, Martha y Sikkink, Kathryn. «International Norm Dynamics and Political Change». International Organization, vol. 52, n.º 4 (1998), p. 887-917.

Notas:

1- No existe una definición de consenso sobre IA, a pesar de los muchos intentos que se han hecho en esta dirección. Hay que tener en cuenta, además, que no existe como tal una IA, sino que este es un concepto paraguas que engloba diferentes tecnologías y aplicaciones. Para complicarlo aún más, las aplicaciones que se suelen adscribir a la IA están en continua evolución.

2- Esto se ve en cómo la legislación ha inspirado otras leyes, por ejemplo, la Ley de Privacidad del Consumidor de California (CCPA) y la Ley de Protección de Información Personal de China (PIPL).

3- De entre estas, destaca la Consumer Privacy Act (CCPA) de California que, ante la ausencia de legislación a nivel federal, se ha convertido en la regulación de facto en este sector.

4- Esta Nota Internacional no emplea el término «norma» y «poder normativo» desde su acepción jurídica (es decir, regla jurídica establecida por una autoridad competente para ordenar el comportamiento mediante la creación de derechos y deberes), sino que lo hace desde la perspectiva del constructivismo social y la gobernanza global. Desde este enfoque, las normas se definen como expectativas colectivas o estándares de comportamiento apropiado (Finnemore y Sikkink, 1998).

5- El GOUAI está liderado por el Programa Ciudades Globales de CIDOB.

6-Los proyectos que se mencionan en esta sección forman parte del Atlas of Urban AI del GOUAI, disponible en el siguiente enlace: https://gouai.cidob.org/atlas

7- Esta estrategia fue elaborada en el anterior mandato, bajo el liderazgo del CTO de Nueva York John Farmer. El nuevo equipo de la Oficina sobre Tecnología e Innovación de Nueva York publicó su Plan Estratégico en octubre de 2022 y, sorprendentemente, no incluye ni una sola referencia a la gobernanza o regulación de la IA. Véase: https://www1.nyc.gov/assets/oti/downloads/pdf/about/strategic-plan-2022.pdf

DOI: https://doi.org/10.24241/NotesInt.2023/286/es